Heute möchte ich noch ein kleines Bastelprojekt vorstellen, welches ich in 2023 für meine Tätigkeit als Blogger umgesetzt habe. Es geht um die Aufrüstung eines Dell Optiplex 7040 SFF auf insgesamt 5 Tbyte SSD/Festplatten-Speicher, etwas was Dell so für dieses Gerätemodell nicht vorgesehen hat, da dieses mit einem schlanken Single Form-Faktor (SFF) Gehäuse ausgeliefert wird. Ich habe es aber mit einigen Tricks geschafft, mehrere SSDs, eine Festplatte und einen optischen DVD-Brenner einzubauen.

Heute möchte ich noch ein kleines Bastelprojekt vorstellen, welches ich in 2023 für meine Tätigkeit als Blogger umgesetzt habe. Es geht um die Aufrüstung eines Dell Optiplex 7040 SFF auf insgesamt 5 Tbyte SSD/Festplatten-Speicher, etwas was Dell so für dieses Gerätemodell nicht vorgesehen hat, da dieses mit einem schlanken Single Form-Faktor (SFF) Gehäuse ausgeliefert wird. Ich habe es aber mit einigen Tricks geschafft, mehrere SSDs, eine Festplatte und einen optischen DVD-Brenner einzubauen.

Das Projekt hat einen besonderen Hintergrund. Seit 2009 war ich für meine Arbeit mit einem irgendwann mit Windows 7 bei Aldi gekauften Medion-PC (Quad-Core-Intel CPU, 2 x 1 TB Festplatten und 4 GByte Arbeitsspeicher, habe ich mir gerne geholt, um zu wissen, mit „was das Volk so unterwegs ist“), lief aber langsam in „Hardwarebeschränkungen“. Hyper-V lief auf der CPU nicht mehr, und auch VMware Workstation kam bei der Virtualisierung an Leistungsgrenzen. Selbst Browsen im Ungoogled Chrome mit vielen Tabs war ein Problem. Für das Bloggen reichte die Leistung aber – und der Rechner hatte durch eine 1 TB Festplatte (System- und einige Datenpartitionen) einiges an Speicherplatz. Zudem unterstützte Medion einen „Datenhafen“, einen Einschub am Gehäuse, in den eine externe Festplatte per eSATA angeschlossen werden konnte. Die ursprünglich 1 TB große Festplatte hatte ich seit einem Festplattendefekt durch ein 2 TB SATA-Modell ersetzt – so dass der Rechner über 3 TByte Plattenspeicher verfügte. Genug Reserve, um meine Manuskripte, die Backups der Blogs, viele VM-Abbilder etc. zu speichern. Aber gelegentlich warf der Rechner einen BlueScreen, der auf die Nvidia-Grafikkarte hindeutete.

Ende 2022 stand ich vor der Frage: „Was machst Du, irgendwann ist der Medion nicht mehr brauchbar oder fällt aus?“. Im Hinterkopf war die Frage „Wie lange wirst Du noch als Blogger unterwegs sein?“. Irgendwann fiel dann der Entschluss, einen refubished Desktop-PC für kleines Geld zu beschaffen und diesen bei Bedarf aufzurüsten.

Der Dell Optiplex 7040 SFF

Hewlett Packard stand auf der „schwarzen Liste“, und ein neues Medion-Gerät wollte ich auch nicht. Ein Fujitsu-PC wäre gegangen – und es gab noch Dell. Nach einer kurzen Recherche auf Refurbished-Plattformen blieb ein Dell Optiplex 7040 SFF übrig.

Der war mit 1 TByte SSD und 16 GByte RAM sowie einem DVD-Brenner ausgestattet, kam aber mit einem schlanken Single Form-Faktor (SFF) Gehäuse. Im Hinterkopf war „Reicht für die ersten Schritte aus, das RAM kannst Du bei Bedarf durch einen weiteren RAM-Riegel auf 32 GByte aufrüsten und vielleicht geht es doch, irgendwie noch eine Festplatte für Backups reinzubasteln“. Der Preis des Geräts beim Refurbished-Anbieter war auch in Ordnung und das Gerät wurde mit einer Windows 10 Professional-Lizenz ausgeliefert – eine Linux-Installation sollte später auf dem Dell auch möglich sein.

Geht das Aufrüsten?

Wie das Leben so spielt, wurde ich von der Wirklichkeit ganz schnell rechts überholt. Der Dell Optiplex stand erst wenige Wochen bei mir „nur zur Erstinbetriebnahme kurz angeschaltet, um zu schauen, ob der Rechner funktioniert“ herum (wenn Du mal Zeit hast, ziehst Du deine Arbeitsumgebung um), als der Medion-Rechner mit Windows 7 plötzlich muckte. Der Bildschirm wurde schwarz und dann ging nichts mehr – ich musste hart ausschalten, um wieder einige Stunden arbeiten zu können.

Also flugs den Dell Optiplex mit der notwendigen Software zum Bloggen und meinen Datenpartitionen eingerichtet und ich war wieder arbeitsfähig. Einige Tage später wurde Windows 10 Professional (22H2) durch ein Windows 10 1909 IoT Enterprise LTSC ersetzt, um bis 2029 Ruhe vor den Microsoft-Basteleien zu haben. Was ich festgestellt habe: Unter der Version 1909 harmonieren Hyper-V und VMware Player nicht, also ist Hyper-V als Rolle deinstalliert worden (gab dort noch einige Probleme, wenn ich nicht unterstützte Linux-Hosts virtualisieren wollte).

Dann kam ganz schnell die Frage „kannst Du den Optiplex aufrüsten und deine 2. GByte SATA-Festplatte in einen freien Slot verbauen?“ auf. Positive Überraschung, die ich vergessen hatte: Der Dell ließ sich ohne Schraubenzieher öffnen und Komponenten konnten über Entriegelungsmechanismen ohne Werkzeug ausgebaut werden.

Wie erwartet, war aber kein zweiter Einschub für eine SATA-Platte vorhanden. Und es gab noch eine unerwartete Überraschung: Nicht mal ein freier Stromversorgungsstecker hing im Gehäuse herum. Aber wenigstens war ein freie SATA-Port samt Kabel sichtbar. Eine kurze Recherche im Internet brachte mich zur Crucial-Seite, wo Upgrades für Arbeits- und Datenspeicher für den Dell Optiplex 7040 SFF angeboten wurden.

Also habe ich mir eine 1 Terabyte PCIe NVMe M.2 SSD bestellt (auf Grund des Preises war mir das Riskio einer 2 GByte NVMe M.2 SSD zu hoch), dann die SSD sowie das optische Laufwerk deinstalliert, um die NVMe M.2 SSD auf dem freien Steckplatz des Mainboards einzubauen. Gab bei der Suche einige Seiten (auch auf YouTube), die das beschreiben – ich selbst bin nicht so der Hardware-Freak und schraube alle paar Jahre mal an den Innereien eines Rechners.

Erinnerungsmäßig habe ich das noch mit dem vorinstallierten Windows 10 22H2 Pro probiert. Dort wurde die NVMe M.2 SSD nach dem Einbau nicht erkannt. Wollte schon fluchen, aber eine schnelle Recherche ergab, dass ich den mal den Intel RST-Treiber (Rapid Storage-Technologie) installieren solle. Danach hatte ich jeweils zwei 1 TByte große SSDs im System verfügbar. Als ich später Windows 10 IoT installierte, wurden die Treiber zur Unterstützung der SSDs automatisch installiert.

Im Hintergrund nagte noch die Frage: Wie kriegst Du deine 2 TByte Datenfestplatte vielleicht in das System eingebaut? Ein erster schneller Test: SSD vom SATA- und Stromanschluss getrennt, Festplatte an die beiden Anschlüsse angestöpselt, zeigte, dass die Festplatte im BIOS auftauchte. Aber es fehlte der Stromanschluss. Eine kurze Suche brachte mich zu diesem Beitrag, wo jemand einen Y-Kabel für die Stromversorgung ins Spiel brachte. Also habe ich auf die Schnelle ein solches Y-Stromversorgungskabel bestellt – und auf eine 4-polige Variante geachtet.

Als das Y-Kabel eintraf, wurde dieses eingebaut, und die zweite Festplatte provisorisch samt SATA-Kabel angeschlossen. Bereits beim Hochfahren sah ich im BIOS, dass die Festplatte vorhanden war und diese wurde nach der Anmeldung an Windows in der Datenträgerverwaltung auch erkannt und konnte eingebunden werden.

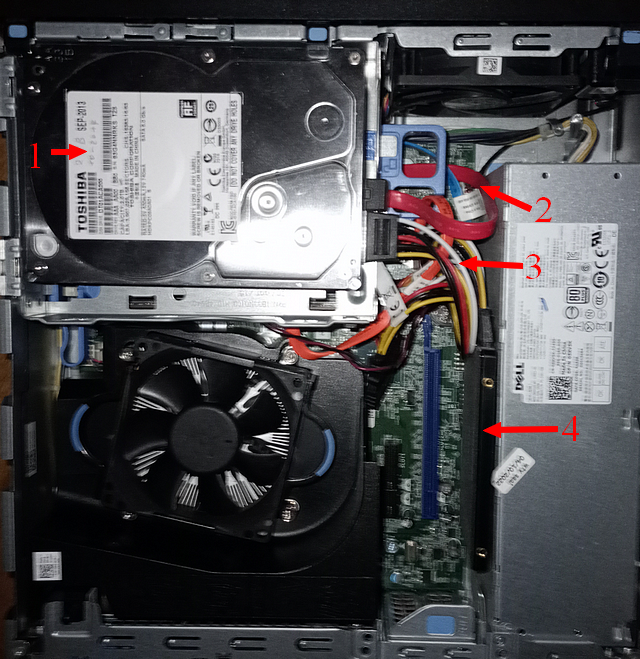

Ich habe es kurz getestet, die Stromversorgung schien ausreichend. Also habe ich den Optiplex im Anschluss kurzerhand umgebaut. Die im Festplatteneinschub montierte SSD wurde ausgebaut und im nun freien Einschub/Rahmen die 2 TByte Festplatte (1) montiert. Dann habe ich ein zweites SATA-Kabel (2) sowie ein freies Ende des Y-Stromversorgungskabels (3) angeschlossen. Die separate SSD (4) wurde neben das Netzteil hochkant im freien Bereich für die PCI-Karte positioniert. Die 2. SSD ist hier nicht sichtbar, da sie unter den Laufwerkseinschüben auf der Hauptplatine montiert ist.

Nachdem ich den Gehäusedeckel wieder montiert hatte, verfügte ich beim Hochfahren über ein System mit 2 x 1 TByte SSDs sowie einer 2 TByte Festplatte. Diese Kombination läuft nun fast ein Jahr störungsfrei und ich kann wieder wie in meiner alten Arbeitsumgebung fuhrwerken.

Am Ende des Tages keimte aber noch der Gedanke: „Du hast ja noch die alte 1 TByte Festplatte mit Windows 7, den Datenpartitionen, einigen VMs sowie deinen alten Daten herumfliegen. Und es gibt noch das nun leere Gehäuse des Medion-Datenhafens. Kannst Du das reaktivieren?“ Das Gehäuse des Datenhafens besitzt neben der eSATA-Buchse noch einen USB-Anschluss und eine Buchse für eine externe Stromversorgung. Ich erinnerte mich, dass Medion seinerzeit für „einiges Geld“ eine externe Stromversorgung angeboten hatte. Aber es müsste doch irgend ein Steckernetzteil mit 12 Volt und 1,5 Ampere tun.

Also in meinen zahlreichen Kisten mit Elektronik-Teilen gewühlt, zig Steckernetzteile mit passenden elektrischen Parametern gefunden, aber bei keinem passte der Hohlstecker für den Stromanschluss. Erst beim letzten Versuch – ein Steckernetzteil von irgend einem Gerät – welches ich schon nicht mehr besaß, hatte den passenden Hohlstecker für den Stromanschluss des Datenhafen-Gehäuses. Also flugs die SATA-Festplatte eingebaut, an das Steckernetzteil gehängt und per USB-Kabel angeschlossen. Auch diese Festplatte ließ sich in der Windows 10-Datenträgerverwaltung einbinden.

So hatte ich am Ende des Tages ein System mit regulär 4 TByte SSD-/Festplattenspeicher, und kann bei Bedarf die alte 1 TByte Festplatte mit Windows 7 und den Daten aktivieren (dort liegt z.B. ein alter Android SDK, den ich beim Schreiben von Android-Büchern für Screenshots benutze). Zudem gibt es die Möglichkeit, für Backups weitere externe USB-Festplatten anzuschließen.

Ist für erfahrene Admins und IT-Dienstleister sicherlich nicht so der Brüller, die wissen sofort, welche Rechner was an Peripherie verkraften. Für mich war es aber eine Gelegenheit, die doch arg angestaubten Hardware-Kenntnisse etwas aufzufrischen und zu testen, was mit Bordmitteln und sonst schmalem Budget im Hinblick auf das obige Projekt geht. Momentan stelle ich fest, dass ich „arg viel freien SSD-Speicher“ im System habe – denn für die geplanten „vielen Linux-, macOS- und Windows Virtualisierungstests“ hatte ich bisher weder Laune noch Zeit. Aber kann ja noch werden – zu viel Speicher ist besser als zu wenig Speicher, sagte meine Großmutter – meinte aber den Speicher, wo das Getreide gelagert wurde. Aber das ist eine andere Geschichte. Schöne Ostern – uns später haben wir Pfingsten – vielleicht kommt mir bis dahin noch „die große Erleuchtung“.

„laut internet“ verwendet man diese art sata adapter nicht, die können wohl intern irgendwie einen kurzschluss bekommen und schmelzen. es gibt nicht-vergossene sata stecker, wie sie auf netzteilen verwendet werden.

hatte selbst auch einen vergossenen jahrelang im einsatz aber wegen der bilder dann doch mal getauscht

suchst Du nach den Fällen und schaust genau nach, sind es schon ominöse Geschichten. Im übrigen hatte ich bei Dell im Forum einen Eintrag gelesen, wo jemand sich wegen des fehlenden Stromanschlusses für eine 2. Festplatte meldete. Ein Dell-Mitarbeiter bat um eine PM, er würde von Dell einen passenden Y-Adapter liefern können. War der Punkt, der mich überhaupt auf die Idee brachte.

> Nach einer kurzen Recherche auf Refurbished-Plattformen blieb ein Dell Optiplex 7040 SFF übrig.

Refurbished wäre mir zu heiss. Fragt man Anbieter von Refurbished Hardware ob sie malwarefreie UEFI Firmware i. S. v. (1) garantieren können, verstehen sie entweder nur Bahnhof oder tauchen ab.

> Stromversorgung schien ausreichend.

Mir wäre unwohl dabei, ohne Kenntnis der Mainboard-Spezifikationen betr. Abwärme und Ströme (nur als Bsp.: (2)) mehr einzubauen, als von DELL vorgesehen. Was anfänglich läuft, kann schon bald die Grätsche machen (3).

(1)

heise.de/news/Microsoft-reagiert-unentschlossen-auf-BIOS-Sicherheitsluecke-BlackLotus-7565992.html

„BlackLotus ist nicht der erste UEFI-Angriff, den Experten in freier Wildbahn nachwiesen. Bereits bekannt sind unter anderem ESPecter (seit 2012), LoJax (2018), FinSpy (2019), MosaicRegressor (2020) und Cosmic Strand (2022).“

(2)

intel.com/content/dam/www/public/us/en/documents/product-specifications/thin-mini-itx-based-pc-system-design-guide-rev-1-2.pdf

(3)

techtarget.com/searchstorage/post/Understand-SSD-overheating-and-what-to-do-about-it

Man kann es auch übertreiben mit den Bedenken. Irgendwann muss man auch mal was schaffen…

Bei der Stromversorgung würde ich mir hier keine Sorgen machen. Der Rechner ist so konstruiert, dass er noch eine Low-Profile-Grafikkarte aufnehmen kann – und die darf sich bis zu 75W genehmigen. Eigentlich könnte man sich mit diesem Power-Budget noch eine RAID-Karte einbauen und 4 SSDs dranhängen, und hätte immernoch Reserven :-)

> Irgendwann muss man auch mal was schaffen…

Eben, deshalb neu/fertig kaufen.

(1) ist durchaus ein valider Punkt, aber man kann ja, wenn man diesbezüglich Bedenken hat, einfach das aktuelle UEFI von der Dell-Webseite installieren.

> einfach das aktuelle UEFI von der Dell-Webseite installieren.

Nein, bringt nichts. Mehrfache Telefonate zwischen 2016 und 2019 mit DELL, HPE und IBM betr. Server ergaben, dass komplette Firmware Images nur ‚im Werk‘ verfügbar sind und auch dort eingespielt werden müssen (per ISP-Hardware (de.wikipedia.org/wiki/In-System-Programmierung)).

In gleiche Richtung gehendes Beispiel aus dem Consumerbereich, s. (1). Beachte den Absatz mit Beginn „So, lenovo provided bios updates …“.

(1)

answers.microsoft.com/en-us/windows/forum/all/biosuefi-virus-survives-clean-install/5ef3088b-6441-4609-b03f-8dfc7c3c4d98

> einfach das aktuelle UEFI von der Dell-Webseite installieren.

Doch noch gefunden, das Black Hat Asia Paper (1) von Matrosov/Rodionov aus 2017 betr. Malware DerStarke, PDF-S. 30: „Can hook firmware update process on-the-fly to keep malicious code active after firmware update“.

(1)

blackhat.com/docs/asia-17/materials/asia-17-Matrosov-The-UEFI-Firmware-Rootkits-Myths-And-Reality.pdf

Schönes Projekt – ich spiele mit dem Gedanken etwas ähnliches mit einem Dell Optiplex 7070 sff anzustellen. Ich will mir aber das optische Laufwerk bewahren. Da ist die Schilderung eines abgeschlossenen Projekts aber schon recht hilfreich.

Danke dafür!

Läuft ja schon unter Bauvorschlag. Was mich an den DELL Kisten immer ein bisschen stört ist die Tatsache, das Dell nur das mitliefert was unbedingt sein muss. Bestellt man die Kiste ohne HDD fehlen die Einschübe grundsätzlich in den Minitower Geräten.

Mein optiplex 5040 benötigte einen Caddy für die 2,5er SSD/HDD. Strom und Kabel waren zur Abwechslung mal dabei. Den Caddy konnte man nicht über eBay oder Ali beschaffen, das ging leider nur via Dell über den Service direkt und 30 Boppen extra. Das ist bei den Server noch extremer – vor allem die unverschämten Preise!

Seit ich Dell durch Wortmann mit Terra Systemen ersetzt habe bin ich erstaunt, das es auch anders geht und alles dabei ist.

Viel Spaß damit! Ich besitze selbst ein sehr ähnliches Dell-Gerät, das seit bald 5 Jahren problemlos läuft. Dual-Boot Windows 10 / Linux Mint, 4 VMs (VirtualBox). Der Ausbau mit Fremdkomponenten (NVMe M.2 500 GB -> 2 TB, RAM 8 GB -> 64 GB) ging auch ohne Ärger. Irgendwann wird noch mein Datengrab (2 TB 3.5“ HDD) durch eine 4 TB SATA-SSD ersetzt, aber das hat noch Zeit.

Das einzige, was man wissen sollte: Bei Volllast wird ein solcher SFF-Rechner SEHR laut. Kommt bei meinem Nutzungsprofil aber selten vor bzw. ich muss dann nicht am Rechner sitzen.

Ich mag solche Projekte. Ich habe seinerzeit privat einen leistungsschwachen, dafür aber stromsparenden HP T5740 Thin Client zu einem 24/7 laufendem Linux Server aufgepimpt, der einen externen SSH Zugriff und einen DLNA Multimedia Server bereitstellt und die Aufnahmen von drei Videokameras entgegen nimmt. Komplett zweckentfremdet und mit wenig Bastelgeschick lassen sich Thin Clients enorm erweitern und als stromsparenden (unter 20 Watt) und komplett lüfterlosen Home-Server verwenden. Das Teil läuft bei mir seit Jahren absolut zuverlässig im Dauerbetrieb, auch wenn der ursprüngliche Verwendungszweck ein komplett anderer war. Ähnliche Projekte habe ich beruflich umgesetzt. So bedient ein ähnliches Gerät eine aus dem Internet zugängliche Next Cloud. Upcycling nennt sich das :-) Thin Clients sind dafür ideal geeignet. Wer Anregungen hierfür sucht wird bei der Webseite „parkytowers“ fündig.

Ich habe seit vielen Jahren immer wieder Computer aufgerüstet und vermeintlich veralteten Computern mehrere Jahre neues Leben gegeben. Beispiele, die heute noch aktiv in Verwendung sind:

– 1 HP EliteDesk 800 G1 USDT (i3, 8 GB RAM, 250GB SSD)

– 2 HP ProDesk 600 G2 (i5, der eine mit 8 GB RAM aus je 4 GB RAM der beiden ursprünglich mit zwei 120er SSDs und dem originalen optischen Laufwerk; mit einem Doppel-Ausgang-DisplayLink-Adapter nun mit 4 Bildschirmen; der andere mit 64 GB RAM (das Maximum des Möglichen), einer zusätzlichen RAID-SATA-Karte und gesamthaft 2 SSDs und 2 SATA-Festplatten (zusätzlich zum originalen optischen Laufwerk), wobei eine der SATA-Festplatten extern per E-SATA angehängt ist

– 2 HP ProBook 6740b (i5, eines mit 8 GB RAM aus je 4 GB RAM der beiden ursprünglich mit einer 250er SSD und dem originalen optischen Laufwerk, das andere mit 16 GB RAM (maxed), ebenfalls einer 250er SSD und einer 1 TB Festplatte statt des originalen optischen Laufwerks)

– 1 Fujitsu Celsius H730 mit i7, 24 GB RAM, einer 250er SSD, einer 2TB Festplatte statt des optischen Laufwerks (im Wechselrahmen) sowie eine 320 GB Festplatte an E-SATA (das Dock hat einen E-SATA-Anschluss)

– 1 Fujitsu Celsius H760 mit i7, 32 GB RAM (hätte sogar noch zwei Slots frei für bis zu 64 GB RAM), einer 500GB SSD und einer 1TB SSD statt des optischen Laufwerks

– 1 Intel NUC NUC10I7FNH mit i7, 1 TB NVMe-SSD, 2 TB Festplatte und 64 GB RAM (als billiger Hypervisor auf der Arbeit; okay, war damals neu, ist also nicht refurbished, würde ich aber auch sofort refurbished nehmen)

– 1 Intel NUC12WSHi5 mit i5, 1 TB NVMe-SSD, 1 TB normaler SSD und 64 GB RAM (als billiger Hypervisor zuhause; okay, war damals neu, ist also nicht refurbished, würde ich aber auch sofort refurbished nehmen)

Meine Erfahrungen mit alten Geräten sind (in der Reihenfolge):

1. Immer interne Festplatten durch SSDs ersetzen, ggf. durch (neue!) Festplatten ergänzen, aber das System immer auf der SSD haben; gebrauchte SSDs funktionieren in der Regel zuverlässig, hier ist eher die Kapazität das Problem als das Alter, solange sie nicht übermässig gebraucht wurden.

2. RAM. Man kann fast nicht genug davon haben. Okay … abhängig vom Einsatzzweck. Normale Feld-Wald-und-Wiesen-PCs sollten sich mit 8 GB oder 16 GB genügen, wer aber Hypervisor einsetzen will sollte mehr davon haben. RAM kostet ja fast nichts mehr. Und häufig erhält man defekte Altgeräte gratis, woraus man den RAM „ernten“ kann (da habe ich seit Ewigkeiten nichts Defektes mehr gehabt)

3. Optische Laufwerke kann man einfach, wenn sie stören, mit Hilfe günstiger Wechselrahmen durch SSDs oder Festplatten (2,5″) ersetzt werden. Geht auch formschlüssig bei den meisten Notebooks, wenn man die originale Blende an den HDD-Rahmen anschraubt. Das optische Laufwerk wiederum kann man in günstigen USB-Gehäusen weiterverwenden. Dann ist man flexibler und soooo häufig werden optische Laufwerke dann doch nicht mehr verwendet. Funktioniert auch mit Spezialsoftware wie DVD-Abspielern oder CD-Rippern (legal besessener CDs, hier in der Schweiz ist die Privatkopie ja erlaubt, in Deutschland bin ich grad unsicher).

4. „Mehr Speicherplatz“ kann man heutzutage auch sehr einfach via externen USB-Festplatten erledigen. Braucht ein extra Netzteil (die 3,5″-Varianten auf jeden Fall, 2,5″ geht oftmals auch über USB-Strom) und ist nicht so schnell wie intern, aber in der Praxis nicht wirklich merklich, es sei denn, man würde ganze virtuelle Maschinen (also grosse Dateien, die viele Gigabytes sind) verschieben. Grosse USB-Sticks und SD-Karten sind auch super-billig geworden, aber häufig nicht so schnell und eines stillen Todes sterbend (auf einmal geht halt gar nichts mehr).

Was mich erstaunt ist, wie irrelevant die CPU heutzutage geworden ist. 2 Cores mit HT, 4 Cores ohne HT, 4 Cores mit HT, … in der Praxis merke ich da echt keinen Unterschied. Die langsamste CPU in der Auflistung oben ist ein i3-4130 mit 2 Kernen und HT und Onboard-Graphik. Wäre das Windows 8.1 da drauf nicht jetzt aus dem Support gefallen, würde ich den PC so wie er ist noch mehrere Jahre so wie er ist weiterverwenden wollen (jetzt kommt da im Sommer Linux drauf, vielleicht auch eine grössere SSD; Windows 10 ist ja auch in den letzten Zügen und Windows 11 wird bei mir nicht mehr vorkommen, dafür ist mir die Gängelung durch MS zu stark geworden, und ich bin seit Windows 2.x dabei). Textverarbeitung, Vektorgraphik, Videos (abspielen, nicht schneiden), viele Dateien offen haben, Webbrowsing mit vielen Tabs, alles möglich und ohne dass das System merklich langsam würde. Nur meine LaTeX-Distribution hat die Grätsche gemacht, weil Windows 8.1 und so weiter. Linux, ich komme!

Was merkbar ist, dass die Akkulaufzeiten der Notebooks unter den oben genannten nicht mehr da sind, wo sie mal waren. Noname-Ersatz-Akkus (da kann man noch wechseln) sind nach meiner Erfahrung nicht vergleichbar mit der Original-Qualität. Also halt Netzteil mitschleppen, wenn man mehr als 45-60 Minuten arbeiten muss.

Einige der oben genannten Geräte, die ich gebraucht erhalten habe, habe ich super-günstig erhalten, weil sie bei meinem Arbeitgeber ausgesteuert wurden und gegen eine nominale Gebühr abgegeben wurden. Daher auch die HP-lastigkeit.

Wie ein Kommentator oben erwähnt hat, sind Thin Clients durchaus ein Teil der Lösung. Aber auch NUCs verbrauchen im Leerlauf unglaublich wenig Strom. Dabei entscheide ich für mich zwischen drei Anwendungen:

1. Fester Client zuhause / auf der Arbeit: braucht vor allem Bildschirmplatz und ein wenig Saft für simple Anwendungen; wenn ich mehr bräuchte, würde ich per Remote Desktop auf eine andere Maschine zugreifen.

2. Mobiler Client zuhause / auf der Arbeit: braucht vor allem Akkulaufzeit und genügend Speicherplatz für aktuelle Dateien, der Rest geht auch übers Netz / VPN+Internet-nach-Hause.

3. Ein mobiler Power-Client für ausserhäusige Spezialanlässe wie Kongresse oder Workshops: hier ist vor allem viel Speicherplatz, eine gute W-LAN-Antenne und die Möglichkeit der Bildschirmerweiterung bei gleichzeitig langer Akkulaufzeit angesagt; hier nutze ich momentan ein 2020er (noch-Intel) Macbook, werde im Laufe des Jahres auf ein 2024er M3-Macbook umsteigen: die können mit einem iPad „Sidecar“, also das iPad als 2. Bildschirm verwenden; früher habe ich hier auch einen USB-powered externen 15″-Monitor verwendet, der per DisplayLink angesteuert wurde.

Und zuhause eben einen HyperVisor, wo man virtuelle Maschinen für den grösseren Bedarf vorhalten kann.

Mittelfristig werde ich Windows nur noch auslaufend und virtuell haben, für die paar Programme, die es halt doch noch nur unter Windows gibt, und auf die ich dann exklusiv per Remote Desktop zugreifen werde. Clients werden dann nur noch Linux oder macOS sein, wobei das nur noch davon abhängen wird, wer die Hardware gemacht hat, denn nachdem ich nun seit 3 Jahren auf einem Client exklusiv mit Linux arbeite (dem H730 oben) und alles super-zuverlässig und kompatibel funktioniert, brauche ich (ausser eben für einige wenige Exoten-Programme) kein Windows mehr. macOS wäre theoretisch auch verzichtbar, wenn ich nicht eine Sonderapplikation (für Musiknoten) hätte, die auf dem iPad und macOS läuft, und wo ich auf macOS komfortabel die Noten für das iPad vorbereiten kann. Aber im Gegensatz zu Microsoft ist macOS nicht so zudringlich (um nicht zu schreiben, übergriffig) was meine Daten angeht und erlaubt es mir, relativ frei zu entscheiden, was ich wie mit welchem Programm mache. Und Teil meiner Arbeit ist es auch, sich auf unterschiedlichsten Systemen in unterschiedlichsten Situationen spontan zurechtzufinden, so dass die Windows-/macOS-/Linux-Flexibilität bleibt.

Was ich noch erwähnen sollte: Daten. Die sind auf einem zentralen Server gespeichert (eine Synology NAS), die auch für bestimmte Zwecke meine eigene Cloud spielt, und die Daten zwischen den Clients synchronisiert und aktuell hält. Hierfür bewährt es sich, dass mein ISP mir drei relativ feste IPs spendiert (ändern sich alle paar Jahre vielleicht mal), worüber ich entsprechende Dienste laufen lassen kann. Ist ein lokaler Anbieter. Somit muss ich mir keine Gedanken machen, wenn ich auf einem Computer mal Daten ändere: sie kommen dann zuverlässig an den anderen auch an, betriebssystemübergreifend und schnell.

Sorry für den langen Post, aber hier ist mal ein Thema, wo ich viel Freude die letzten Jahrzehnte hatte und ich hoffentlich Mut machen konnte, alter Hardware ein zweites oder drittes Leben zu geben. Gerade wenn man selber administriert. Hier ist auch eine echte Chance: viele Firmen wollen nach gewisser Zeit ihre Systeme systematisch austauschen, weil sie möglichst wenige verschiedenartige Clients gleichzeitig warten wollen, oder weil zu viele dieser Clients irgendwelche Probleme anfangen zu machen. So kann man günstig an diese Geräte kommen und entweder aus mehreren eines machen oder von 5 vielleicht 3 funktionierende auswählen und die anderen als Ersatzteilspender in den Keller legen. Für eine Firma würde sich der Arbeitsaufwand nicht lohnen, aber als Privatbastler ist das allemal günstiger (und ja eben auch spannend).

Bei Wortmann gibt es eben nach einigen Jahren keinerlei Update zu Ihren Produkten. Ist irgendwie wie bei Android Handys.

Ich habe mir 2015 ein gebrauchtes Fujitsu Notebook gekauft.

Habe dann Windows 10 installiert und eine 2 TB SSD eingebaut.

Das Notebook das nun mittlerweile 13 oder mehr Jahre alt sein dürfte läuft immer noch einwandfrei und bekommt auch monatlich seine Updates.

Mag daran liegen, dass Wortmann, wie so viele andere „Hersteller“, nur das eigene Label draufklebt. Die Terra Notebooks von Wortmann sind z.B. vom OEM Hersteller Clevo. Damit ein schönes Terra Logo beim Booten angezeigt wird, müssen die BIOS Versionen natürlich angepasst werden und für Wortmann entstehen bei jedem Update entsprechende Kosten.

Merke: You get what you pay for.

> Meine Erfahrungen mit alten Geräten sind (in der Reihenfolge): …

Nicht böse gemeint, aber ich finde den Upcycling-Elan der sowohl bei Senioren als auch der (grünen) Jeunesse anzutreffen ist, puncto Informationssicherheit verheerend.

Sie erwähnten kein einziges Mal das Upgraden von Firmware; vermutlich weil es Sie entweder nicht kümmerte oder Sie schlicht keine Updates/Patches für die jüngere Zeit mehr fanden.

Ich betreue nebenbei – mehr schlecht als recht – eine Handvoll Senioren, die auf ihren Online-Konten liquide Mittel teils bis in den mittleren sechsstelligen Bereich herumschieben. Da möchte ich niemanden sehen, der noch mit so altem Geraffel mit kaputter weil hoffnungslos veralteter, resp. unsicherer Firmware unterwegs ist.

Schlimm genug, dass wir i. Z. mit der Ende 2023 bekanntgewordenen LogoFAIL UEFI-Lücke (1) immer noch massenhaft auf Updates warten müssen.

(1)

csoonline.com/de/a/it-sicherheitsforscher-warnen-vor-uefi-firmware-schwachstellen,3681197

Nehmen wir einmal an, dass Du recht hast, und dass neuere Systeme tatsächlich sicherer sind als ältere (was in meinen Augen alles andere als erwiesen ist).

Dann kann es doch trotzdem keine Lösung sein, einwandfrei funktionierende Geräte, die alles können, was der Nutzer braucht, alle paar Jahre wegzuwerfen und durch neue zu ersetzen, oder? Sondern stattdessen müsste, notfalls durch gesetzliche Vorgaben, dafür gesorgt werden, dass bekanntgewordene Lücken, die in der Verantwortung des Hardware-Herstellers liegen, eben auch bei älteren Geräten gestopft werden. Und mit „älter“ meine ich heute, wo es für den Standard-Nutzer kaum noch relevanten Hardware-Fortschritt gibt, nicht 3 Jahre, sondern 20 Jahre.

Ist beispielsweise im Auto- oder Flugzeug-Bereich ja auch so.

Wer seine Argumentation mit Beschimpfungen zu untermauern meint, gibt direkt zu, dass seine Aussage inhaltlich nicht zu überzeugen vermag.

Es gibt durchaus Systeme, die kein UEFI unterstützen oder bei denen man Legacy Boot aktivieren kann, nicht jedes System ist gefährded und es macht ja auch noch einen kleinen Unterschied zwischen Notebooks, die in wechselnden WLANs betrieben werden und Linux Servern, die in weitestgehend isolierten Netzen stehen und nur über wenige Ports erreichbar sind.

Die Abkürzung SFF steht für „Small Form Factor“, es gibt auch noch MFF-Gehäuse, das sind dann „Micro Form Factor“.

Ich liebe solche Projekte und setze stark auf gebrauchte Business-Geräte, die halten noch ewig, vor allem mit Linux.