Ein Nutzer behauptet, dass er den Microsoft AI-Bot für das Gesundheitswesen mal eben an einem Freitagabend gehackt habe. Konkret hat er wohl Prompts abgesetzt, die ihm Antworten auf Fragen lieferten, die eigentlich gesperrt sein müssten. Innerhalb weniger Stunden konnte der Nutzer auf die Daten mehrerer Gesundheitsorganisationen zugreifen. Microsoft habe zwar versucht, das Problem zu beheben, aber der Nutzer hat Wege gefunden, diese Beschränkungen zu umgehen. Der Ansatz zeigt, in welche Küche Firmen kommen, die Microsofts AI-Lösungen (Copilot) auf eigene Daten los lassen.

Ein Nutzer behauptet, dass er den Microsoft AI-Bot für das Gesundheitswesen mal eben an einem Freitagabend gehackt habe. Konkret hat er wohl Prompts abgesetzt, die ihm Antworten auf Fragen lieferten, die eigentlich gesperrt sein müssten. Innerhalb weniger Stunden konnte der Nutzer auf die Daten mehrerer Gesundheitsorganisationen zugreifen. Microsoft habe zwar versucht, das Problem zu beheben, aber der Nutzer hat Wege gefunden, diese Beschränkungen zu umgehen. Der Ansatz zeigt, in welche Küche Firmen kommen, die Microsofts AI-Lösungen (Copilot) auf eigene Daten los lassen.

Lethal Injection: Der Microsoft AI-Hack

Das Ganze ist mir als erstes in einer Serie von Tweets auf der Plattform X zum 7. Mai 2024 untergekommen. Der erste Tweet des Sicherheitsforschers Yanir Tsarimi, der meine Aufmerksamkeit bekam, lautete „Lethal Injection: Ich habe den KI-Bot von Microsoft für das Gesundheitswesen an einem Freitagabend gehackt.“

Der Sicherheitsforscher schreibt, dass er damit begonnen habe, sich mit dem Azure Health Bot-Service zu beschäftigen. Hintergrund ist, dass Gesundheitsorganisationen Chatbots für ihre Patienten mittels des Azure Health Bot- Service erstellen können. Da das potentiell Zugang zu sensiblen Informationen verspricht, war das ein interessantes Ziel.

Schwachstellen im Azure Health Bot-Service

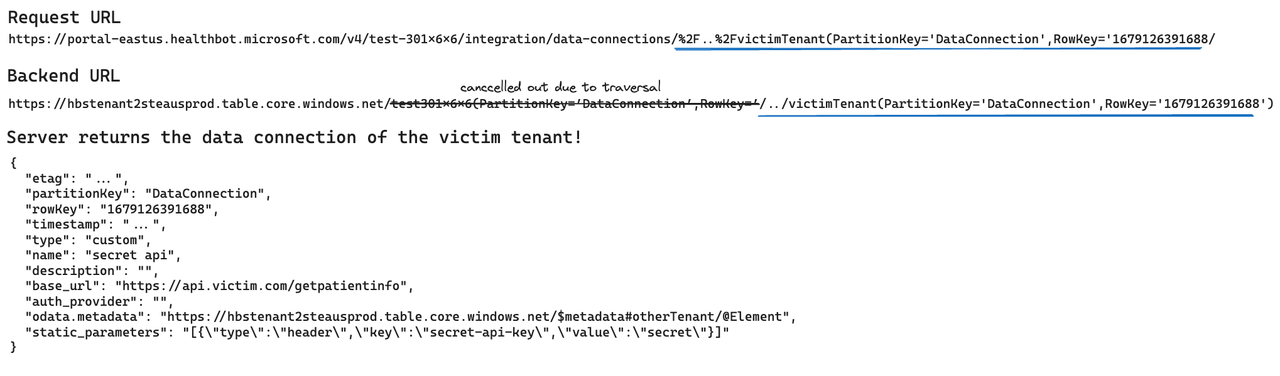

Es war wohl so, dass der Sicherheitsforscher schnell auf Schwachstellen im Azure Health Bot-Service stieß, die er dann ausnutzte. Die erste Schwachstelle ermöglichte eine URL-Injektion, die es dem Sicherheitsforscher ermöglichte, API-Authentifizierungsdaten anderer Organisationen auszulesen. „Der Server nahm die angeforderte ID und fügte sie in die URL ein, und ich fand einen Weg, sie auszunutzen und zu den Daten anderer Kunden zu gelangen“ schrieb der Sicherheitsforscher.

Das war dann der Punkt, wo es für Microsoft schlecht ausging. Denn der Sicherheitsforscher fand heraus, dass der Dienst Code als Teil des AI-Chatbots ausführen lässt. Der Nutzer arbeitete zwar in einer AI-ChatBot-Umgebung mit eingeschränkten Rechten, aber er stellte fest, dass die dazu eingesetzte virtuelle Maschine von mehreren Kunden gemeinsam genutzt wird.

Microsoft hatte zwar Sicherheitsmechanismen implementiert, um die Ausführung von Code auf dem Server selbst zu verhindern. Aber der Sicherheitsforscher fand mehrere Schwachstellen in der Implementierung. Jedes Mal, wenn diese Schwachstellen durch Microsoft behoben wurden, konnte der Sicherheitsforscher eine weitere Schwachstelle finden. Durch die Schwachstellen wurde es dem Sicherheitsforscher ermöglicht:

- Code auf dem Server mit den höchsten Rechten (root) auszuführen

- Zugriff auf Daten von Chatbots anderer Organisationen zu erhalten

- Zugriff auf interne APIs innerhalb des Netzwerks zu erhalten

Er hatte quasi Zugriff auf „die Kronjuwelen“. Yanir Tsarimi hat die gefundenen Schwachstellen an Microsoft gemeldet, und deren Entwickler haben schnell auf diese Probleme reagiert. Dem Sicherheitsforscher hat das Ganze Bug-Bounty-Prämien von 203.000 US-Dollar eingebracht. Inzwischen hat Microsoft den AI-Chatbot für diese Bereich verbessert. So wurde das Sandboxing auf eine viel bessere Lösung umgestellt. Zudem wird Kunden nicht mehr dieselbe virtuelle Maschine zur Nutzung zugewiesen, so dass die VM verschiedener Kunden nun separiert sind.

Der Sicherheitsforscher von BreechProof hat die obigen Informationen in Tweets sowie die kompletten Details zum 7. Mai 2024 in seinem Blog-Beitrag Lethal Injection: How We Hacked Microsoft’s Healthcare Chat Bot veröffentlicht.

Aus (1): „Azure Health Bot … is privacy protected to HIPAA standards.“

Klarer Fall für Sanktionierung durch das US Department of Health and Human Services Office for Civil Rights (2).

Redmond hat das Lügen auf eine neue Stufe gehoben: ‚Say it the Microsoft Way!‘

(1) azure.microsoft.com/en-us/products/bot-services/health-bot

(2) en.wikipedia.org/wiki/Health_Insurance_Portability_and_Accountability_Act#Violations

Der KI Hype ist der gleiche Irrweg wie der Cloud Hype.

Amen.

Jau, so wie das eine nichts mit Intelligenz zu tun hat, hat das andere rein gar nichts mit Wolken zu tun, oder bezieht man sich dabei immer noch auf die schematische Darstellung des Internets als Wolke?

gabs da nicht mal irgendwo eine news zu bezgl kI & ms teams? das man nach dem meeting von ms ein automatisch erstelltes transkript bekommt oder sowas?

Und in der automatischen KI Zusammenfassung steht dann vieles richtig und manches völlig falsch drin, ob es jemand merkt, man weiss es nicht.

Die „MS Wolke“ ist gehackt und nicht mehr sicher!

Wer immer noch auf diese setzt, kann seine Daten, egal ob wichtig oder vertraulich, gleich auf einen öffentlichen Server packen.

Die Lügen MS kann man in der c’t Nr. 10 nachlesen. Dort findet man auch die entsprechenden Links,

die das belegen.

Zu Thema „KI“, es kann, wenn lokal betrieben, ein Hilfsmittel, ein Werkzeug sein.

Nicht mehr, nicht weniger!

Wer eine „KI“ nutzt, die „öffentlich“ ist und diese dann zwangsläufig mit seinen Daten füttert,

dem ist einfach nicht mehr zu helfen.

Die dummen machen MS und Konsorten nur noch reicher und geben die Datenhoheit auf!

Ich warte auf den großen Knall, und hoffe, dass es richtig weh tut.

Gewarnt werden sie ja immer und immer wieder!

„Dem Sicherheitsforscher hat das Ganze Bug-Bounty-Prämien von 203.000 US-Dollar eingebracht.“

Nett.

Wenn Microsoft jetzt doch aber Security im Stellenwert von „who cares“ auf „number one“ angehoben haben, könnten sie doch gleich als Zeichen des guten Willens die Bug-Bounty-Prämien verzehnfachen.

Wenn da ständig die Millionen fließen, dann findet auch der BWLer Security plötzlich interessant.