[English]Momentan rappelt es mal wieder mit der (Microsoft) IT-Infrastruktur – wie ich bereits von einigen Blog-Lesern vernommen habe. Wie es ausschaut, sitzt Microsoft bereits seit gut 8 Stunden dran und hofft, das Ganze so langsam in den Griff zu bekommen. Die Störung tritt weltweit auf und Blog-Leser Michael meinte dazu „Irgendwas ist los in der Welt… Flughafen BER und Palma stehen wohl komplett“ – ist Urlaubszeit. Der globale Ausfall trifft wohl alle Stellen, die eine Lösung der Cybersecurity-Firma CrowdStrike verwenden – deren letztes Update führt auf Windows-Hosts zu BlueScreens. Wer deren Dienst nutzt, ist momentan offline – wobei es schon einen Workaround gibt. Ich versuche mal das Thema etwas zu sortieren – es ist aber „Work in Progress“. Der Ausfall von Microsoft 365 scheint übrigens ein unabhängiges Ereignis zu sein.

[English]Momentan rappelt es mal wieder mit der (Microsoft) IT-Infrastruktur – wie ich bereits von einigen Blog-Lesern vernommen habe. Wie es ausschaut, sitzt Microsoft bereits seit gut 8 Stunden dran und hofft, das Ganze so langsam in den Griff zu bekommen. Die Störung tritt weltweit auf und Blog-Leser Michael meinte dazu „Irgendwas ist los in der Welt… Flughafen BER und Palma stehen wohl komplett“ – ist Urlaubszeit. Der globale Ausfall trifft wohl alle Stellen, die eine Lösung der Cybersecurity-Firma CrowdStrike verwenden – deren letztes Update führt auf Windows-Hosts zu BlueScreens. Wer deren Dienst nutzt, ist momentan offline – wobei es schon einen Workaround gibt. Ich versuche mal das Thema etwas zu sortieren – es ist aber „Work in Progress“. Der Ausfall von Microsoft 365 scheint übrigens ein unabhängiges Ereignis zu sein.

Erste Lesermeldungen

Erste Lesermeldungen erreichten mich per Mail und über Facebook sowie X. Auf X schrieb mir jemand „Microsoft hat gerade wohl richtige Probleme. Siehe Twitter unter Microsoft die Beiträge. BSODs. Hat wohl was mit Crowdstrike zu tun.“. In weiteren Posts heißt es, dass die Infrastruktur am Flughafen in Berlin zur Zeit „down sei“. In meinem Postfach stapeln sich zudem die Hinweise der Leserschaft (danke dafür).

Der Artikel hier schreibt, dass Flughäfen, Züge, Rundfunksender etc. betroffen sind. Bei n-tv meldet man, dass auch Tankstellen und Banken betroffen sind. Stand 19.7.2024, 11:00 Uhr, gehe ich davon aus, dass ein Großteil der weltweiten Windows-Infrastruktur (dort, wo CrowdStrike in Unternehmen eingesetzt wird) steht.

Muss darauf mit einem Witz mit Bart kontern: „Ich habe es gesehen, nachdem ich vom Augenarzt zurück war“, war aber gerade beim Doc, als erste Meldungen bei mir einschlugen – aber beim Doc lief KIM noch.

Update: Aktuell werde ich von zig Benachrichtigungen erschlagen – da steht wohl weltweit die IT-Infrastruktur. Der Beitrag ist daher Work-in-Progress und wird stückweise erweitert.

Microsoft meldet Probleme mit MS 365

Zwischenzeitlich meldete auch Microsoft Probleme mit Microsoft 365 Apps und Diensten. Ich hatte ursprünglich angenommen, dass es mit obiger Störung zusammen hängt. Aber der CrowdStrike-Update-Bug und der Ausfall von Microsoft 365 sind unterschiedliche Ereignisse, die rein zufällig überlappend auftraten. Bei Microsoft 365 war es eine Azure Fehlkonfiguration. Ich habe daher die Details hier herausgezogen und im Blog-Beitrag Weltweiter Ausfall von Microsoft 365 (19. Juli 2024) aufbereitet.

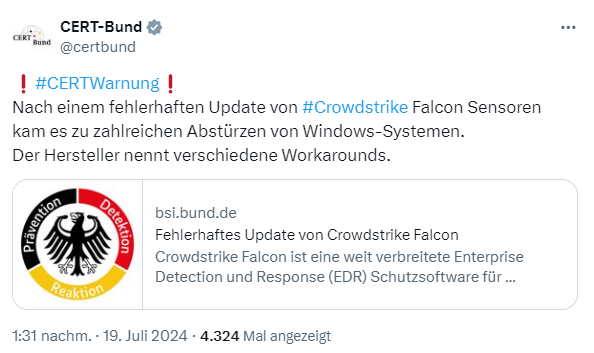

BSI: Kein Cybervorfall

Ergänzung: Das Bundesamt für Sicherheit in der Informationsverarbeitung (BSI) meldete heute Mittag, dass es sich um keinen Cyberangriff handelte.

Das deckt sich mit meinen Erkenntnissen und das BSI schreibt in seiner Mitteilung Fehlerhaftes Update von Crowdstrike Falcon:

Crowdstrike Falcon ist eine weit verbreitete Enterprise Detection und Response (EDR) Schutzsoftware für Endgeräte. Während des Betriebs werden regelmäßig Softwareupdates mittels sogenannter Channel-Dateien ausgerollt. Mit Hilfe der Channel-Dateien verteilt Crowdstrike dynamische Updates und Detektionsregeln.

Durch ein jüngst ausgerolltes fehlerhaftes Update, welches die auf Endgeräten und Servern installierten Crowdstrike Falcon Sensoren betrifft, kam es zu einer Situation, die unter Windows zu Abstürzen führen kann.

CrowdStrike-Update verursacht BSOD-Boot-Loop

In diesem Kurzbeitrag lese ich, dass ein weltweiter Ausfall die Cybersicherheitsfirma CrowdStrike getroffen und mehrere Regierungsbehörden und australische Unternehmen in Mitleidenschaft gezogen habe. Auf reddit.com gibt es diesen Thread mit dem Titel „BSOD error in latest crowdstrike update“.

We have widespread reports of BSODs on windows hosts, occurring on multiple sensor versions. Investigating cause. TA will be published shortly. Pinned thread.

SCOPE: EU-1, US-1, US-2 and US-GOV-1

Das letzte Update für die unter Windows zum Endpunkte-Monitoring eingesetzte Software der Cyber-Sicherheitsfirma CrowdStrike führt zu BlueScreens auf Windows-Systemen. Es gibt bei CrowdStrike im Supportportal wohl einen Eintrag „Windows crashes related to FalconSensor“ (ich komme mangels Benutzerkonto nicht an die Details.

Ergänzung: Dank eines Lesers kann ich näheres mitteilen, da ich den Engineering-Report einsehen konnte. CrowsStrike hat wohl Rückmeldungen über Abstürze auf Windows-Hosts im Zusammenhang mit dem Falcon Sensor erhalten. Es wird dann so umschrieben:

- Zu den Symptomen gehören (Windows) Hosts, bei denen im Zusammenhang mit dem Falcon-Sensor ein Fehler auf dem Bildschirm auftritt.

- Mac- oder Linux-basierte Hosts sind von diesem Problem nicht betroffen.

Den Update-Bug hat man mit dem Rollout des Channel-File „C-00000291*.sys“ (mit einem Zeitstempel von 05:27 UTC oder später) beseitigt, indem man das Update rückgängig gemacht hat. Sofern Hosts immer noch abstürzen und nicht in der Lage sind, online zu bleiben, um die Änderungen an den Kanaldateien zu empfangen, können die nachfolgenden Workarounds durchgeführt werden, um obiges Problem zu umgehen.

Schnelle Workarounds, um arbeitsfähig zu werden

Inzwischen gibt es wohl Workarounds, mit denen betroffene Windows-Systeme wieder arbeitsfähig gemacht werden können. Ein Workaround, der auf reddit – als Lösung des CrowdStrike Engineering – beschrieben wird, lautet:

- Boot Windows into Safe Mode or the Windows Recovery Environment

- Navigate to the C:\Windows\System32\drivers\CrowdStrike directory

- Locate the file matching “C-00000291*.sys”, and delete it.

- Boot the host normally.

Also die Windows-Systeme im abgesicherten Modus booten, dann im oben angegebenen Verzeichnis die Daten löschen und das System neu booten. Der Workaround wirkt aber nicht, wenn man weltweit Tausende an Windows-Systemen wieder zum Leben erwecken will. Lars hat mir auf Facebook in einer PM folgende Hinweis geschickt, wie er die Systeme wieder zum Laufen gebracht hat (danke dafür):

In der CrowdStrike-Console beim Deploy die Sensor Version auf 11 stellen. Dann alle Windows Server und Windows Clients neu starten – kann mehrfach erfolgen.

Lars schrieb mir dazu: „Damit kommen wir gerade wieder auf die Beine ohne weltweit jeden Rechner anzufassen zu müssen. Bis jetzt nur 1 Server der aus dem Backup geholt werden musste.“ Danke an Lars für den Hinweis – vielleicht hilft es weiter.

Auch die Cloud betroffen

Inzwischen liegt mir auch die CrowdStrike-Information des Workarounds für öffentliche Clouds oder ähnliche Umgebungen vor:

- Trennen Sie das Betriebssystem-Diskvolumen von dem betroffenen virtuellen Server.

- Erstellen Sie einen Snapshot oder ein Backup des Festplattenvolumens, bevor Sie fortfahren, um unbeabsichtigte Änderungen zu vermeiden.

- Hängen Sie das Volume an einen neuen virtuellen Server an bzw. mounten Sie es.

- Navigieren Sie zum Verzeichnis C:\Windows\System32\drivers\CrowdStrike

- Suchen Sie die Datei mit der Bezeichnung „C-00000291*.sys“ und löschen Sie sie.

- Trennen Sie das Volume vom neuen virtuellen Server

- Verbinden Sie den festen Datenträger wieder mit dem betroffenen virtuellen Server

Entspricht im Prinzip dem oben skizzierten Ansatz zum Restaurieren von Bar-metal-Systemen. Bleibt zu hoffen, dass nur wenige Systeme wiederbelebt werden müssen.

Microsoft Azure VMs tangiert

Auch die virtuellen Maschinen in Microsoft Azure sind wohl betroffen. Microsoft hat auf dieser Azure-Status-Seite eine entsprechende Meldung veröffentlicht.

Awareness – Virtual Machines

We have been made aware of an issue impacting Virtual Machines running Windows Client and Windows Server, running the CrowdStrike Falcon agent, which may encounter a bug check (BSOD) and get stuck in a restarting state.

Updated: We approximate impact started as early as 04:09 UTC on the 18th of July, when this update started rolling out.

GPO zur Reparatur

Ich weiß nicht, ob es umsetzbar ist. Aber auf GitHub hat jemand eine GPO gepostet, um die Dateien im abgesicherten Modus zu entfernen.

Stopp: Fehlerhaftes Update knipst IT-Infrastruktur weltweit aus?

Der Vorfall ist ein wunderbares Beispiel, wie kaputt das gesamte IT-Eco-System im Prinzip ist. Da liefert ein Cloud-Sicherheitsanbieter ein fehlerhaftes Update aus, und schickt damit alle Windows-Clients in den digitalen Orkus. An Flughafen geht nichts mehr, Banken stehen, Tankstellen schließen und so weiter. Aber es kommt noch besser:

- Bei meiner Recherche war recht schnell klar, dass es am fehlerhaften Update von CrowdStrike liegt. Ich kannte sogar die URL des Support-Beitrags, kam aber nicht weiter, weil das nur mit Anmeldung abrufbar war. Als Broadcom das für die VMware-Supportbeiträge versucht hat, gab es einen Aufschrei. Bei CrowdStrike haben es alle gefressen? Wie verstrahlt müssen die IT-Entscheider dieses Planeten sein?

- Bei Microsoft habe ich auf X im Kanal @MSFT365Status bisher (Störung seit gut 9-10 Stunden) noch nichts zu CrowdStrike lesen können. Da heißt es nur, dass man langsam mit der Infrastruktur hoch komme. Inzwischen weiß ich, dass der Microsoft-Ausfall nichts mit dem CrowdStrike-Problem zu tun hat (auch wenn ich vermutete, dass Microsoft intern auch CrowdStrike in seiner Cloud einsetzt, war es wohl ein Azure-Konfigurationsfehler, der den Ausfall verursachte).

- Wie bereits in den nachfolgenden Kommentaren erwähnt: Es werden ständig grundlegende Prinzipien der IT-Ausfallsicherheit verletzt – ein „Single Point of Failure“ sorgt dafür, dass an Flughäfen nichts mehr geht, Tankstellen streiken, Züge nicht mehr disponiert werden können, Kassensysteme beim Einkauf streiken, und die Hälfte der Firmen nicht mehr arbeitsfähig ist. Tegut hat wohl Mitarbeiter nach Hause geschickt.

Ich gehe davon aus, dass heute Schäden in Milliarden-Höhe anfallen, weil die IT-Infrastruktur steht. Aber ich formuliere es mal so: Die Welt ist mit einem „blauen Auge“ davon gekommen. Man stelle sich vor, es hätte einen Lieferkettenangriff auf CrowdStrike gegeben und statt eines fehlerhaften Updates wäre Malware eingeschleust worden, die dann eine Killsoftware oder Ransomware nachlädt.

Wie schreibt Prof. Dennis Kipker (hat eine Professur für IT-Sicherheit( auf X: „Absoluter Worst Case und Grund, warum wir der Cloud kein unbegrenztes Vertrauen schenken sollten! Von KRITIS über Staat bis zu Industriebetrieben. Bestes Beispiel dafür, dass das Mantra „IT aus der Steckdose“ ein Holzweg ist!“

Dem ist wohl nichts hinzuzufügen – außer: „Das ist alternativlos“; „Ist Software vom Marktführer“; „Das machen alle so“; „Kann man nichts machen, ein Akteur mit unglaublich krimineller Energie hat unsere Systeme kaputt gemacht“ – ups, jetzt habe ich beim Wortphrasen-Automaten die falsche Taste gedrückt, die letzte Aussage bitte streichen – obwohl mich auch schon Fragen nach einem Cybervorfall in diesem Kontext erreichten.

Ähnliche Artikel:

Weltweiter Ausfall von Microsoft 365 (19. Juli 2024)

Ausfall von Microsoft 365 und weltweite Störungen – wegen CrowdStrike-Update, was zum BSOD führt?

Wieso weltweit zahlreiche IT-Systeme durch zwei Fehler am 19. Juli 2024 ausfielen

CrowdStrike-Analyse: Wieso eine leere Datei zum BlueSceen führte

Nachlese des CrowdStrike-Vorfalls, der bisher größten Computerpanne aller Zeiten

Geht in die Cloud haben sie gesagt, das ist Ausfallsicherer als im eigenen RZ haben sie gesagt.

Tja wenn du Crowdstrike in deinem RZ oder auf deiem Client system einsetzt warst du genauso betroffen!

Da machen Sie aber eine Milchmädchenrechnung, relevant ist die Verfügbarkeit über Zeitraum X, z.B. das Kalenderjahr und nur das ist auch vergleichbar bzgl. Cloud vs. RZ.

Also, über die letzten drei Jahre aktiver Cloudnutzung hatten wir mehr Ausfälle von, bzw. Probleme mit, Clouddiensten als mit vergleichbaren Systemen on-prem.

Na, das ist doch mal eine Aussage, mit der man arbeiten kann – insbesondere (falls belegbar) gegenüber dem Management.

Ich kann hingegen nicht klagen, von 4 Clouddiensten fiel laut meinem Monitoring in den letzten 2 1/2 Jahren (seit Einstieg Cloud) nur der Billigst-VPS-Anbieter aus und dort hoste ich nur Verzichtbares (im Wesentlichen Sync- und externes Monitoring meines Monitorings).

Was ja auch kein Wunder ist, denn bei Cloud hat man viel mehr Points of Failure als bei OnPrem.

Schon rein theoretisch ist daher die Ausfallwahrscheinlichkeit von Cloud gegenüber OnPrem höher.

Hier genau so. Sogar noch krasser: Seit dem Wechsel in die MS Cloud (wollte die GF) gab es in 2 Jahren mehr Ausfälle, als in 25 Jahren On-Prem.

Aber ist ja Industriestandard und wenn die anderen auch down sind, kann keiner mit dem Finger auf einen Zeigen…

Naja. Das ist wohl alles relativ.

Wie viele Dienste nutzen Sie on Prem?

Ein wenig von Diesem, ein wenig von Jenem.

Bei M365 haben Sie aber einen ganzen Packen davon, der von den MA zur effizienteren Gestaltung der Arbeit/Produktivität genutzt werden kann und wird.

Heißt im übertragenen Sinne, on Prem 5 Sachen, Cloud 50 Dinge. Das da mehr Potenzial für mögliche Fehler existiert liegt auf der Hand, ist aber im Vergleich relativierbar.

Vielleicht ist es nur Glück, aber unsere On-Prem-System hatten die letzten Jahre genau einen Ausfall, für ca. 4 Stunden. Ja, ist eine sehr kleine Umgebung, aber trotzdem. Meiner Ansicht nach verspricht die Cloud wesentlich mehr als sie halten kann.

Deine Spruche schon tausendmal gelesen. Gäähn

Nicht nur das. Auch sicherer, billiger und besser haben sie gesagt. Wurde alles nicht eingehalten. Aber genug Verträge sind wohl unterzeichnet, dass sich das vor allem die großen Konzerne das leisten können. Und die Kunden gewöhnen sich daran. Insbesondere die CEOs, denn ein deutscher CEO irrt sich bekanntlich nie ;)

works as designed ;-)

Microsofts weltweit wankende Wolkenschlösser. 😂

In diesem Fall hat es aber nicht mit Microsoft direkt zu tun, sondern mit der Sicherheitssoftware von CrowdStrike. Sprich, wie im Text zu lesen sind nur die Betroffen die diese Software nutzen, scheinbar ist das auch bei Microsoft 365, dem Frankfurter Flughafen und so einigen anderen IT-Firmen der Fall.

Jein, warum kann eine Software das OS so lahm legen. Sollte da nicht ein Fallback-by-Design da sein?

Crowdstrike setzt wie viele andere Programme auf die Wolken-Infrastruktur von MS auf und reißt sie mit zu Boden. Mit derben Auswüchsen. Das UKSH in Kiel z. B. hat für heute alle OPs abgesagt. Erstaunlicherweise fährt die Bahn noch.

ja aber es war kein Ausfall von Crowdstrike (weil zb die MS Cloud die die ggf. benutzen down war), sonder Crowdstrike hat ein defektes Update ausgeliefert was, in diesem Fall, „nur“ unter Windows ein crash verursacht hat.

Moin,

hatte die Bank nicht noch Win 3.11 im Einsatz??

https://www.borncity.com/blog/2024/01/29/meme-sucht-die-deutsche-bahn-einen-windows-3-1-administrator/

Gruß

Die Bahn fährt noch, weil die Crowdstrike-Software nicht auf Windows XP läuft… Somit laufen die Maschinen ja auch noch alle.

Und Windows 7/Server 2003. Das steht im Crowdstrike Artikel sogar als nicht betroffenes System neben GNU/Linux und MacOS drin :D

sieht ja wohl eher so aus als wenn CrowdStrike der Verursacher ist und massig Windows Systeme lahmgelegt hätte (wie es sowas schonmal bei anderen Virenscannern etc in der Vergangenheit gegeben hat) und nicht MS selber.

Ist Move-in-Progress – inzwischen ist CrowdStrike thematisiert.

Mit Linux wäre das nicht passiert.

https://www.crowdstrike.de/produkte/faq/

Crowdstrike läuft auch auf Linux. Wer sagt dir das es bei einem anderen Crowdstrikeupdate crash auf einem Linux System verursacht wird.

Wir setzen den CrowdStrike Sensor auf diversen Linux Systemen ein. Da hat heute nix gewackelt, im Gegensatz zu Windows.

Ja weil bei DIESEM Update Windows gestört wurde,

wer sagt das das alle (unterschiedliche) OS betreffen muss.

Und vor allem wer sagt dir dass das beim nächsten mal nicht auf Linux und gleichzeitig eben NICHT auf Windows auftritt.

Mal ein blöder Autovergleich:

Wenn Raffinerie XY Benzin und Diesel herstellt und an Tag X der Diesel Müll ist, dann ist der Hersteller von Dieselmotoren der Verursacher weil die Benziner ja nicht betroffen waren?!

Hat nichts mit Windows zu tun, sondern einzig und allein mit Crowdstrike. Ein fehlerhaftes Update könnte auch Linuxmaschinen lahmlegen.

Bisher habe ich nie was von einem Linux BSOD gehört – höchstens von Kernel-Panik. Natürlich könnte ein CrowdStrike-Update der Sensoren für Linux fehlerhaft sein. Ich vermag nicht zu sagen, ob das dann Linux auf’s Kreuz geworfen hätte.

Ich finde es ja total spannend: Es ist ein Incident passiert, der die IT des halben Globus in die Knie gezwungen hat. Halber Globus heißt Schnittmenge „der Windows-Systeme“ und „CrowdStrike im Einsatz“. Und was passiert? Ich stolpere ständig über Aussagen „hat nichts mit Microsoft zu tun, war CrowdStrike“ oder „hat nichts mit Windows zu tun …“ – hab mal a bisserl gemalt – merkste was?

Die neue Mode ist sich kaskadierende Abhängigkeiten zu schaffen und dafür noch zu bezahlen. Bricht ein Glied der Kette, war es das dann. Kurzer Schmerz – Augen zu und weiter. IT Kindergarten eben.

Najaaaaaa… Der Kommentar ist schon arg weit hergeholt und eigentlich nicht das „Günter Born“ Niveau, wie wir es eigentlich hier in diesem Blog kennen.

Lade unter Linux ein fehlerhaftes Kernelmodul und der Kernel wird ebenso panisch.

Das hat rein gar nichts mit Microsoft zu tun, außer dass die erlauben, dass in Ebenen des OS rumgemurkst wird, wo 3rd party Software nichts verloren hat. Aber das wird in Linux ebensowenig unterbunden.

Aber wie schon an anderer Stelle geschrieben: Ein großen Teil der Schuld trifft m. E. die IT-Enscheider, die sich von Herstellern der Sicherheitsprodukte einlullen lassen und das Zeugs lizenzieren.

Der Markt ist nicht ohne Grund so riesig.

Ich haette ja jetzt „sie arbeiten daran“ gepostet, aber in Wahrheit ist BSoD-on-Linux schon fertig:

https://www.phoronix.com/news/Linux-DRM-Panic-BSoD-Picture

Oha – also, wenn ich über so was blogge, sorge ich dafür, dass das am 1.4. erscheint – bin ich wieder von der Wirklichkeit rechts überholt worden.

Geht noch besser…

„Den gleichen Dummfug wie heute geschehen mit Windows gab es Ende April auch für Debian Linux 12 nach dem Update auf Kernel Version 6.1.0-20 im Kombination mit falcon-sensor version 7.10 bis 7.14. Offizieller Workaround: deinstallieren und warten auf neue Version oder Software im „user mode“ laufen lassen.“

— https://blog.fefe.de/?ts=9864a262

> Ich finde es ja total spannend: Es ist ein Incident passiert, der die IT des halben Globus in die Knie gezwungen hat.

Dann ist es aber kein Incident mehr, sondern ein Major.

Da mehrere Anwender / Kunden betroffen sind.

So ganz spontan fiel mir der abgewandelte Spruch „Unternehmen sind nicht insolvent, sie hören nur auf, zu verkaufen“ von Robert ein: „Software kann per se nicht kaputt gehen, sie hört einfach auf zu funktionieren“. Und jetzt geht der Hausmeister erst mal relaxen.

Siehe https://blog.fefe.de/?ts=9864a262:

„Den gleichen Dummfug wie heute geschehen mit Windows gab es Ende April auch für Debian Linux 12 nach dem Update auf Kernel Version 6.1.0-20 im Kombination mit falcon-sensor version 7.10 bis 7.14. Offizieller Workaround: deinstallieren und warten auf neue Version oder Software im „user mode“ laufen lassen.“

„Halber Globus“ halte ich bei etwa 20% Marktanteil von Crowdstrike beim Einsatz von Enterprise-AV/EDR für etwas übertrieben, Trellix/ex-McAfee und MS-Defender scheinen die ärgsten Konkurrenten zu sein.

Ich sagte ja auch nicht, dass es was mit Windows zutun hatte, sondern dass das Problem, wie es heute Morgen unter Windows auftrat, auf unseren Linux Systemen, die ebenfalls den Crowdstrike Sensor installiert haben, nicht aufgetreten ist.

Auf unseren Windows Systemen hingegen trat das Problem auf. Zum Glück nur im kleinen Rahmen.

„Mit Linux wäre das nicht passiert“ das Statement ist derart abgedroschen und total überflüßig…

ne, es kann nicht oft genug wiederholt werden. Vielleicht kapieren es dann wenigstens ein paar der MS Betonkopfkunden

Im April dieses Jahres gab es ein ähnliches Problem im Kernel von Linux verursacht durch CrowdStrike. Also, das Problem ist, wie auch in der Natur, Monokultur. Niemand kann das perfekte System erstellen, selbst die Chinesen nicht!

xz war sogar ein Sicherheitsvorfall, absichtlich herbei geführt, und nicht mal ein versehentlicher Programmierfehler. Früher (TM) als ich es ernsthaft noch versucht habe, Linux anstelle von Windows einzusetzen, hatte ich mehrfach Kernel-Panics durch Updates weil durch das Update ein Kernel-Modul – meistens der WLAN-Treiber – abschmierte. Das ist durchaus vergleichbar mit jetzt Crowdstrike. Einer der Gründe, warum ich dieses Frickel-Textadventuere mir nicht mehr antue.

Mit Linux wäre viel nicht passiert.

z.B. Software und Hardware würde nur bedingt laufen, so wie die Kooperation/Interaktion mit anderen Firmen.

Die Welt ist größer als dein Spielzimmer.

… sagte Gigabernie, der nichtmal weiß, wo Linux überall im Einsatz ist

Mit C64 wäre das nicht passiert

Mit dem Amiga 4000 auch nicht aber das geht grad am Thema vorbei denn darauf läuft CrowdStrike glaub ich nicht. Auf Linux68k sicher auch nicht.

Wir verwenden die Sicherheitslösung Proofpoint, der Service ist nicht erreichbar, ergo kein Mailversand möglich. Gottseidank das einzige Problem welches wir aktuell haben. Das wird heute ein heißer Tag für Systemadmins die CrowsStrike im Einsatz haben.

Erschreckend ist aber wie einfach die Cloudinfrastruktur sich in die Knie zwingen lässt und dadurch ein weltweiter Ausfall entsteht.

Witzig finde ich die Helden die in den Kommentaren div. Seiten schreiben das man auf Mac oder Linux umsteigen soll und Microsoft bashen. Die haben die Cloud verstanden ;)

Dieses einkloppen auf Microsoft liegt aber auch an den Nachrichten, die gleich etwas von Microsoft schreiben. z.B. Tagesschau: „Microsoft-Update…“.

Nein, eben nicht Microsoft, sondern eben das Update einer Sicherheitssoftware von CrowsStrike.

Bei Microsoft habe ich auch nach 8 Stunden auf X nichts von „schaut bei CrowdStrike nach“ vernehmen können.

Falls Du (mangels M365-Abo) diese Mails nicht bekommst:

Start time: Thursday, July 18, 2024, at 9:56 PM UTC

Preliminary root cause: A configuration change in a portion of our Azure backend workloads, caused interruption between storage and compute resources which resulted in connectivity failures that affected downstream Microsoft 365 services dependent on these connections.

Next update by: Friday, July 19, 2024, by 8:30 AM UTC

Das ist zwar korrekt, aber ist ein ganz anderer Vorfall. Der hat nicht mit CrowdStrike zu tun.

https://www.tagesschau.de/ausland/it-panne-computer-global-100.html

Mittlerweise haben dies es auch mitbekommen

“ Die Störung könnte mit einem Antivirenprogramm zu tun haben.“

„Der mögliche Ausgangspunkt könnte aber ein Problem bei der US-Cybersicherheitsfirma Crowdstrike sein.“

Naja vom Microsoft Bashing halte ich auch wenig.

Allerdings muss ein Virensoftwarehersteller an die Schnittstelle andocken. Und wenn Microsoft an dieser Schnittstelle Änderungen macht liegt das nun mal auch zu einem Teil an Microsoft. Es ist jetzt die Frage ob von Microsoft verlangt werden kann alle Sicherheitslösungen darauf zu testen, ob da noch inkompatibilitäten existieren?

Noch kann den Sicherheitsfirmen ein Vorwurf gemacht werden

das die von den Änderungen seiten Microsoft nichts wussten.

Der Treiber lief ja noch bis heute. Also hat es ja eine Änderdung gegeben.

Wie bereits geschrieben hat dies ja in der Vergangenheit bereits diverse Firmen getroffen. Insofern wäre es doch interessant zu wissen warum? Und ob Microsoft da nicht vielleicht doch eine Lösung findet dass dies nicht gleich zu einem Blue Screen führen muss.

Es war kein Update einer Betriebssystemschnittstelle, das dürfte auch klar sein denn sonst hätte es das Problem schon unmittelbar am Patchday gegeben. Es war ein Programmierfehler im Update der Crowdstrike Software selbst.

Was kann Microsoft dafür? Der Fehler liegt ausschließlich bei CrowdStrike; der fehlerhafte Treiber ist deren Baby!

Nope,

wenn man in der Liga spielen will muss man auch sowas in Minuten kompensieren können.

Gruß

Hauptsache möglichst immer erstmal die Schuld bei MS suchen. Wenn jemand mit einem Hammer dein Notebook kaputt kloppt ist das ja auch der Notebook-Hersteller Schuld. Hätte der ja mal stabiler bauen können….

Kommt auf die Sichtweise an: Wenn der Hammer nicht kaputt geht, war das Teil gut ;-)

Solche Firmen müssen zwangsweise geschlossen werden und die Geschäftsführer jahrelang ins Gefängnis wandern, weil sie solche Kill-Switches verbreiten, also entweder keine Tests durchgeführt haben oder absichtlich die Weltwirtschaft sabotieren.

Man muss ja keine Inkompetenz unterstellen, wenn man auch Absicht unterstellen kann.

Sämtliche Administratoren, die sowas ohne Tests auf Produktivsysteme installiert haben müssen ebenfalls abgemahnt und nachgeschult werden.

Wenn man Affen im Zoo mit Cybersecurity beauftragen würde, dann würden solche Fehler nicht passieren.

Daraus folgt, diese Firma und die Admins sind dümmer als Affen im Zoo.

Gemeinsam haben alle, dass sie hin und wieder mit Scheiße schmeißen.

Du verlangst von Administratoren, dass sie jedes Update einer Anti-Viren-Software vorher testen? Ein bisschen an der Realität vorbei gedacht, oder?

Die automatischen Updates erlaubt man nur für die Testsysteme.

Wenn die Testsysteme die Updates ohne Probleme überstehen, dann reicht man die Updates intern weiter an die Produktivsysteme.

Die Produktivsysteme dürfen niemals direkten Zugriff auf die Update-Server des Herstellers haben, denn sonst hat auch der Hersteller direkten Zugriff auf die Produktivsysteme.

Virenscannerupdates kommen teilweise mehrfach am Tag.

Was macht du sonst noch so in deinem Leben?

Sie haben definitiv nicht verstanden, um was es sich bei Crowdstrike handelt.

Warum zahlt man wohl Unsummen für eine Sicherheitssoftware, die zeitgelöst agiert und aktualisiert wird?

+1

CrowdStrike aktualisiert regelmäßig Pattern- und sonstige Dateien, die für die Erkennung von Angriffen, Malware und wasweißich benötigt werden. Das tut jeder Hersteller von Antivirensoftware ebenfalls.

Zeig mir bitte den Admin, der mehrmals am Tag Updates für solche Paterndateien in einer Testumgebung ausrollt und erst danach die Produktivsysteme damit beglückt. So jemanden wird es vermutlich nicht einmal in den großen Firmen dieser Welt geben, die sich eine solche dedizierte Position leisten könnten – und das werden die wenigsten sein.

In manchen Branchen muss man der jeweiligen Aufsicht gegenüber jederzeit nachweisen (!) können, dass alles (!), was produktiv geht, vorher getestet wurde. Das sind dann vermutlich die Branchen, die von diesem Vorfall anscheinend wenig betroffen sind. Erschreckenderweise gehören Krankenhäuser wohl nicht dazu.

Was hast Du denn geraucht? Das ist ein automatisierter Update Prozess, da greift keiner der lokalen Admins mehr ein und testet. Das ist Thema von Crowdstrike. Hast Du Aktien bei denen und gerade 10% verloren oder was soll das vollkommen überzogene Gebashe?

Da müssen nicht mal die Admins was für können, wenn sich die tolle Software (mutmaßlich) die Updates automatisch zieht und installiert machst du da gar nix… Da ist dann eher die Frage wer so nen scheiß kauft.

Erinnert mich an die Vorstellung von Windows Update damals wo Microsoft zum Thema Updates meinte „Überlassen Sie alles uns!“.

Jeder weiß was dabei raus kommt…

Kleine Anmerkung; ok, wenn’s da um sowas wie Pattern für Antivirus und co geht, das muss logischerweise automatisch erfolgen…

Ich gehe einmal davon aus, dass das Update auf Windows von der Sicherheitsfirma getestet wurde. Vermutlich gibt es da noch weitere Komponente(n) die hinzugekommen ist und in dem Test nicht berücksichtigt wurde. (Entweder ein neues Windows Update, oder eine zusätzliche Software)

Ohne detaillierte Hintergründe, kann man da finde ich in diesem Fall schwer jemanden verurteilen.

Genau so einen BSOD Loop hatte man Vater vor Jahren wegen einer internen Intel GPU. Der Driver wurde von MS automatisch installiert. Das löste einen BSOD aus, den konnte man nur mehr beheben indem man den Driver im Dateisystem (entweder mit Linux – oder mit der Windows Wiederherstellungskonsole) durch den alten ersetzte. Dann fuhr man den Rechner hoch, Windows lief wieder und installierte nach 1Minute wieder den Intel Driver, der dann wieder den BSOD auslöste…

Hätten viele User die selbe alte iGPU am Motherboard gehabt, wäre das auch entsprechend ausgeartet…

Theorie und Praxis sind zwei verschiedene Welten. Klar, theoretisch sollte man sämtliche Updates vorher in einem Testsystem abklopfen bevor man es auf ein Produktivsystem loslässt. Zeig mir aber einen Firma welche deren IT die entsprechende Manpower zur Verfügung stellt. Du müsstest jedes einzelne Update von der Sicherheitslösung bis zu den div. Programmen überprüfen und deren Funktionalität durchspielen, das ist unrealistisch.

Zumal Testsysteme und Produktivsysteme niemals identisch sind. Wenn ein Update auf dem Testsystem läuft, heißt das noch lange nicht, dass das Produktivsystem das Update ebenfalls veträgt.

Man kann das Risiko minimieren, aber es wird niemals gleich Null. Allerdings ist der Aufwand mit Testsystem enorm zeitintensiv und kostet dementsprechend, wobei die aktuellen Kosten durch den Schadenn ebenfalls beträchtlich sind. Wie man es macht, macht man es verkehrt.

@Bolko

Kannst Dich ja dort bewerben und die Welt besser machen… Wenn sie Dich lassen…

> Sämtliche Administratoren, die sowas ohne Tests auf Produktivsysteme installiert haben müssen ebenfalls abgemahnt und nachgeschult werden.

Während der Installation hat ja noch alles funktioniert. Das ist erst durch ein Update kaputtgegangen.

Und in größeren Unternhemen treffen nicht die Administratoren eine Entscheidung für oder gegen ein IT-Produkt, sondern das machen Entscheidungsträger, die in der Regeln kein IT-Detailwissen haben und sich daher von Herstellern von Sicherheitsprodukten gerne einlullen lassen.

Zusatzprodukte haben noch nie für eine wirklich gute IT-Sicherheit gesorgt, weil es ein ewiges Wettrüsten ist und mal sind die Angreifer besser, mal die (Un-)Sicherheitssoftwareanbieter.

Was am besten schützt sind an das Unternehmen angepasste Prozesse. Produkte können schützen. Aber niemals alleine.

Und dafür sind in der Regel weder die Admins verantwortlich, noch CrowdStrike (die wollen ihren Mist auch nur verkaufen, um Kohle zu verdienen, was man ja irgendwie nachvollziehen kann, wenn man es geschafft hat, ein „haben will“-Gefühl bei Entscheidungsträgern zu erzeugen).

Tja, ist halt ein Softwareproblem, da kann man nix machen…

Stehende Flughäfen klingt jetzt aber ein wenig extrem. Hätte nicht gedacht, dass da so viel an der Cloud hängt.

Wenn doch, dann müssen das interessante Verträge sein. So ein Flughafenstillstand geht von den Kosten her ja schnell in die Millionen. Nur für den Flughafen, also ohne Flugausfälle…

Beim BER sollte alleine der Schuldendienst deutlich über eine Million am Tag aufwerfen.

Na dann, Daumen gedrückt, dass es nichts Schlimmeres ist.

Crowdstrike killt auch „lokale“ Systeme

lokale RZ nutzen auch Crowdstrike

„Hätte nicht gedacht, dass da so viel an der Cloud hängt.“

alles hängt da drin…

weiterer möglicher workaround zum Crowdstrike-Problem (nicht selbst geprüft):

https://www.heise.de/forum/heise-online/Kommentare/Weltweiter-IT-Ausfall-Flughaefen-Banken-und-Geschaefte-betroffen/Fix-fuer-uns-15K-Clients/posting-44220551/show/

Habe es inzwischen aus anderer Quelle nachgetragen – danke.

Und sie zetern und jammern wieder, obwohl es wieder vorhersehbar war. Und sie werden genau nichts ändern…

Kein Mitleid.

Willkommen wieder mal im Grundkurs IT Sicherheit, Thema heute:

Single Point of Failure

Wenn man die Dateien löscht:

C:\\Windows\\System32\\Drivers\\CrowdStrike\\C-00000291*.sys

Was dann weiter?

Soll man CrowdStrike ohne diesen Treiber im System lassen und das funktioniert dann sicher?

Kann ich mir und will ich mir nicht vorstellen.

Die Software braucht doch diese Treiber und ohne hat man Lücken im System, weil die Security gar nicht mehr aktiv ist und mit CrowdStrike-Cybersecurity hat man das Damoklesschwert über einem hängen, dass jederzeit so ein Mist wieder passiert.

Also muss CrowdStrike komplett runter.

Die sabotierten Systeme sind auch als kompromittiert anzusehen und müssen vollständig gelöscht und ohne CrowdStrike neu aufgebaut werden.

Man kann ja nicht iwssen, was die Software sonst noch so verändert hat und ob es noch weitere solche Kill-Switches gibt und man weiß auch nicht, ob das Fahrlässigkeit oder Absicht war.

Unterstellen muss man immer Absicht, denn man muss vom Schlechten im Menschen ausgehen, gerade in diesen Zeiten.

Wenn man nur von Fahrlässigkeit ausgeht, und es war aber tatsächlich Absicht, dann wird der Schaden nur noch größer.

Trau schau wem.

Also runter mit allem und mehrmals gründlichst nass durchwischen.

Wenn man die Wahl hat zwischen „geht gar nicht“ und „geht etwas unsicherer“, wird man wohl den letzteren Weg gehen und sich im Zweifelsfall von einer schreienden, krebsrot angelaufenen Person der passender Vergütungs- bzw. Bonusstufe absegnen lassen. 🤣

Ich kenne Crowdstrike nicht näher, vermute aber daß dann dieser Treiber nicht geladen wird – wenn er nicht als kritisch markiert ist gibt es nur eine Fehlermeldung.

Was dann passiert (ob Crowdstrike dann den nächstälteren „matching“ Treiber – etwa C-00000290*.sys lädt oder zumindest der Autoupdater wieder läuft und man – hoffentlich – einen inzwischen korrigierten bekommt) müssen die Leute hier beantworten, die dieses Produkt kennen.

PS: Hier spüre ich im Moment keine Auswirkungen.

Man kann annehmen, dass CrowdStrike das Problem inzwischen behoben hat und dass nach einem Reboot ohne diese Datei, die gefixte Version davon installiert wird.

Nur zur Ergänzung für Mitleser – ich habe am Artikelende in einem Link auf einen Folgebeitrag mit einer Analyse verwiesen, warum es zum fatalen Fehler kam.

Es liegt an Crowdstrike, nicht an Microsoft.

Es gibt 2 Probleme, die parallel aufgetereten sind:

* Ausfall von Cloud-Diensten bei Microsoft 365 und Azure

* Crowdstrike BSOD

Es ist in der Berichterstattung nicht ganz klar, welches Real World Problem (z.B. lahmgelegte Flughäfen) mit was zusammenhängt. Der Spiegel z.B. berichtet, dass dass Flughafen-Problem an der Cloud liegt.

Wie kommst du darauf, dass die Probleme nicht einfach zusammenhängen? Crowdstrike kann auch auch auf Cloudservern der angesprochenen Dienste laufen…

Vielleicht nutzt Microsoft bei M365 ja auch CrowdStrike auf den Servern, weil die ihrem eigenen Defender-Müll nicht vertrauen… :D

Woher weißt du das es zwei verschiedene Probleme sind und nicht einfach das MS ggf auch Crowdstrike nutzt?

Vermutlich läuft auf den Hosts in der Microsoft-Cloud CrowdStrike und der legt diese lahm.

Yo G, bitte nimm doch mal „Microsoft 365“ aus dem Header ;)

Ich glaub es liegt an Crowdstrike

Es liegt an CrowdStrike. Betroffen sind alle Windows Clients, Linux/Mac sind nicht betroffen.

Workaround:

Boot Windows into Safe Mode or the Windows Recovery Environment

Navigate to the C:WindowsSystem32driversCrowdStrike directory

Locate the file matching “C-00000291*.sys”, and delete it.

Boot the host normally.

Die gefixte „C-00000291*.sys“ Datei wird dann im Nachgang von CS neugeladen.

Quellen:

https://news.ycombinator.com/item?id=41002195

Ältere erinnern sich an Cyberpolygon, here we are…

Lieber Günter, ich verfolge deinen Blog seit vielen Jahren und schätze dich und deine Arbeit für die Community sehr. Deshalb möchte ich höflich aber deutlich zum Ausdruck bringen, dass die folgende Aussage in meinen Augen populistisch ist und schlicht nicht der Realität entspricht:

Zitat: „Der Vorfall ist ein wunderbares Beispiel, wie kaputt das gesamte IT-Eco-System im Prinzip ist. Da liefert ein Cloud-Sicherheitsanbieter ein fehlerhaftes Update aus, und schickt damit alle Windows-Clients in den digitalen Orkus. “

Es ist sicherlich nicht alles toll in der Welt. Das Problem hier, dass ein Virenscanner ein Update verteilt und damit Windows abschießt, das gab es vor 20 Jahren auch ohne Cloud schon. Damals waren es halt die täglichen Signaturupdates.

Wir haben vor 15 Jahren neue Signaturen immer erst an 100 Clients verteilt und nach einigen Stunden erst weiter gestreut. Und wir hatten irgendeinen Trigger, dass das Rollout der Signaturen gestoppt wird, wenn plötzlich in größerer Anzahl Virenmeldungen auftauchen.

Das ist aufgrund der aktuellen Bedrohungslage aber aus einer anderen Zeit. Du schreibst ja selbst sehr regelmäßig über Angriffe. Darin kritisierst Du nicht zu Unrecht, dass Unternehmen und Institutionen sich nicht ausreichend schützen. Wenn man heute so einen Trigger im AV-Management hätte, dann könnte es auch der Verschlüsselungstrojaner sein, den der Virenscanner für einen false positive hält und gewähren lässt. Der Admin, der das so einstellt, der würde von der Commity mit Spott überzogen werden.

Heute haben alle die Oberwasser, die bei Updates immer zurückhaltend sind. Gestern haben wir noch über die IT’ler gelästert, die das Sicherheitsupdate von letzter Woche nicht installiert haben. Wir drehen uns immer schön mit dem Wind und lästern ohne schlechtes Gewissen über die dummen Admins, uns selbst würde das ja niemals passieren.

Es gibt leider immer Menschen, die hinterher immer alles schon vorher gewusst haben. Dass die QS bei Crowdstrike vielleicht nicht den besten Job gemacht hat (wissen wir nicht), das mag sein. Es gibt hier häufig Kommentare aus der Kategorie, die nehme ich als Meinungsäußerung kopfschüttelnd zur Kenntnis.

Dass Du als Betreiber dieses Blogs das schreibst, finde ich schade. Eigentlich hat der Blog ein höheres und vor allem sachlicheres Niveau verdient.

Zitat :“Es gibt leider immer Menschen, die hinterher immer alles schon vorher gewusst haben.“

Ganz meine Meinung.

Ich bekomme im Schnappatmung, wenn Leute rückblickend immer alle gewusst haben wollen, dabei aber das Wissen von heute ansetzen und nicht das vor 1 Woche, 1 Jahr oder 20 Jahren.

+1

Ich finde die Aussage trifft es auf den Punkt. Genau das ist doch das Problem, dass ein Update eines einzelnen Sicherheits-Herstellers die halbe Welt lahmlegt. Da geht es um aufgeblasene Systeme, alte Zöpfe, die nicht mehr abgeschnitten werden (können), Monopole usw.

Diese ganze Misere ist wirklich ein Beispiel für die Probleme der Systeme. Und wenn kritische Infrastruktur mit einem System betrieben wird, welches für seine teilweise veralteten Schnittstellen steht, dann muss man sich die Frage stellen, ob das so Verantwortungsvoll ist.

Sehr schön und treffend geschrieben Tobi.

Ist schon wahnsinnig wie jedes einzelne Mal tausende Besserwisser auftauchen… Ich frag mich immer ist es so schwer zu verstehen?

1. Geräte können ausfallen

2. Dienste können ausfallen

3. Software kann fehlerhaft programmiert sein

4. Heute trifft es das eine Produkt, morgen das nächste

5. Jede Strategie (sofort patchen vs. erstmal ausgiebig testen) hat Vor- und Nachteile

6. Keiner kann alle möglichen Ausfälle und Szenarien vorhersehen

Wie du eben richtig schreibst ist es bei der Bedrohungslage die wir seit Jahren haben nicht möglich jedes Update die womöglich noch eine Zero-Day-Lücke schließt erstmal zu testen.

Also Leute bitte einmal tief Luft holen, kurz nachdenken und nicht gleich besserwisserisch draufhauen. Mir tun alle IT-Kollegen leid die jetzt kein ruhiges Wochenende haben.

Schönes WE an alle

Klasse Kommentar, sehe ich ebenfalls so.

DANKE !!!

Genau das beobachte ich in diesem Blog LEIDER auch zu oft.

Das ist sicher gut für’s Klima!

Ja, Zufälle gibt’s… ich sage nur „Fridays for future“…

Meinst da hat jemand bewusst an den Schräubchen gedreht? :-D

Ist das jetzt wirklich ein Cloud Problem oder „einfach“ ein Softwareproblem aufgrund sehr tiefer Systemintegration ?

Normale Antivieren Software kann sich ja wohl auch ziemlich tief im System verankern.

Bei CrowdStrike scheint es sich um Software aus dem Bereich kritische Infrastruktur zu handeln (oder ähnlich). Ich bin da kein Experte.

Ein Pannen Update kann also noch stärkere Ausfälle verursachen.

Wenn also CrowdStrike ein entsprechend fehlerhaftes Update ausliefert, dann kann das natürlich andere Auswirkungen haben, als von einem kleinen Software Entwickler.

Oder liege ich da falsch ?

Meiner Meinung nach müsste CrowdStrike die gleichen Sicherheitsanforderungen und Tests bzgl. Updates erfüllen wie MS.

In Anbetracht der Pannen von MS müssten die Qualitäts Anforderungen von CrowdStrike eigentlich sogar höher sein.

Hallo Jungs und Mädels,

heute ist Freitag. Da viele Benutzer/Benutzerinnen im/aus dem Home Office arbeiten, können die Administratoren doch ruhig mal etwas zur Blutdruckanhebung gebrauchen ;-), sonst schläft man ja ein.

Und man könnte den Feierabend / das Wochenende verpassen. ;-)

Im Ernst, ich finde das schon bedenklich.

Und sowohl in den Büchern „Andreas Eschbach“ in „Blackout“, wie auch „Wolf Harlander“ in „Systemfehler“ werden solche Szenarien sehr gut beschrieben.

Wie kommt man eigentlich auf die Idee, eine Firma „CrowdStrike“ zu nennen?

Übersetzt:

Die „Menschenmenge streikt“.

Dann passiert auch noch so ein Vorfall mit dieser Software, wodurch es tatsächlich zu streikähnlichen Ausfällen kommt.

Hm, so spontan hatte ich CrowdStrike mit „die Menschheit schlagen“ (Crowd = viele Leute, Strike = Schlag) im Hinterkopf. Aber ich gestehe, als Absolvent des 2. Bildungswegs hatten wir nur 2 Jahre Englisch – und in der Volksschule durfte ich a bisserl Englisch lernen, damit das „Hey man, do you have chocolate or bubble gum“ an der nahen Air Base klappte. Vielleicht kriege ich deshalb die Übersetzungen nicht hin – aber Deepl sagt wirklich „Massenstreik“ oder „Massenauflauf“ – passt also auch ;-).

„strike“ wird zwar durchaus mit „Streik“ übersetzt, ist aber auch zB beim Bowling („Alle Zehne!“) oder Baseball der „Treffer“.

Gehe also eher davon aus, dass sie den Namen als „Schlag/Treffer der Masse“ verstanden wissen wollten.

Auch wenn es eher ein Anschlag *gegen* die Menschenmasse war, wie man es ebenfalls interpretieren kann..

ich sag nur

https://www.borncity.com/blog/2017/04/10/windows-7-bluescreen-nach-avast-update/

https://www.borncity.com/blog/2019/10/24/symantec-antivirus-bringt-google-chrome-78-zum-absturz/

https://www.borncity.com/blog/2022/05/17/windows-11-update-kb5013943-erzeugt-bluescreens-mit-sophos-treiber/

Aus welchem Grund heißen die Dateien mal C-00000291abc.sys und mal C-00000291999.sys

Ein Treiber sollte doch immer den selben identischen Dateinamen haben.

Außerdem gibt es keinen Grund, warum man Pattern, also Schädling-Signaturen, mit in einen Treiber packen sollte.

Das kann man auch in eine extra Datei auslagern.

Der Treiber muss so robust sein, dass er auf keinen Fall das Betriebssystem in einen BSOD schickt.

Er muss also die Hashes der Betriebssystem-Dateien kennen und auf eine Whitelist setzen. Das würde das OS vor fehlerhaften Pattern schützen.

hexadezimal?

So geht moderne IT. Ein kleines Sandkorn im Getriebe und nix geht mehr. Brauch nicht einmal einen Cyberangriff, sondern nur ein schlecht getestetes Update und weltweit steht vieles still. Wer konnte auch so etwas ahnen?

Wichtig ist nur am Ende ist keiner Verantwortlich / kann man nichts gegen machen. Die Russen und Chinesen stehen als ‚die waren es‘-Buhmann leider nicht zur Verfügung.

Vereinheitlichung ist super, bis sowas passiert.

Vielleicht sollte man bei redundanten Systemen doch keine Monokultur fahren. Also zumindest auf dem Teil A Virenscanner X und auf dem Teil B Virenscanner Y verwenden.

Könnte die Verfügbarkeit retten. Aber was weiß ich schon als kleines Licht.

Bei uns läuft bisher alles stabil in der MS365 Cloud…

CrowdStrike verwenden wir nicht.

Heute mal wieder festgestellt:

Monokultur ist ein Problem. Was nützen einem redundante Systeme für Fileserver, Anwendung und Datenbank wenn auf Teil A und Teil B das gleiche Schlangenöl läuft?

Mal sehen ob hier jemand lernwillig ist.

Das ist tatsächlich ein guter Ansatz.

Und viele Antiviren-Admins soll ein Unternehmen beschäftigen, die das jeweilige Produkt bis ins kleinste Detail kennen?

„strike“ wird zwar durchaus mit „Streik“ übersetzt, ist aber auch zB beim Bowling („Alle Zehne!“) oder Baseball der „Treffer“.

Gehe also eher davon aus, dass sie den Namen als „Schlag/Treffer der Masse“ verstanden wissen wollten.

Auch wenn es eher ein Anschlag *gegen* die Menschenmasse war, wie man es ebenfalls interpretieren kann..

@Günter:

Kann weg! (siehe oben; hatte Kommentar hier zwar gelöscht, aber offenbar ist dies nach Beginn des 20min-Countdowns nicht mehr möglich!?)

passierte mir auch schon mind. 2x, ist echt ärgerlich/unnötig.

Ich vermute einen Fehler in (Hr. Borns) WordPress(-Instanz), gelöschte Kommentare werden nicht gelöscht, sondern laufen in die Moderation und Hr. Born sieht dort nicht, dass man löschte.

Tja,

dann schon mal planen wie man seine VMs und seine Geräte verschlüsselter Platte bootet.

Bei unverschlüsselten Platten kann man sich ja per USB, ISO oder PXE behelfen .

Bei Laptops mit Bitocker und geschützem Bootprozess etc. wird das ein Thema in Konzernen die weltweit Notebooks zentral verwalten.

Das Wochenende ist gelaufen. Die Pizzabuden werden richtig Umsatz machen.

Gruß

wenn ich das richtig verstanden habe, sind es zwei Probleme die recht zeitlich unabhänging von einander auftragen.

1.) Cowdstrike hat fehlerhafte Updates ausgeliefert

2.) Microsoft hat wiedermal Mist bei M365 gebaut

Oder betrifft das Crowdstrike Problem auch direkt Microsoft?

1.) Cowdstrike hat fehlerhafte Updates ausgeliefert

Das ist korrekt.

2.) Microsoft hat wiedermal Mist bei M365 gebaut

Microsoft setzt wohl Crowdstrike bei M365 ein.

Oder betrifft das Crowdstrike Problem auch direkt Microsoft?

Ja, denn MS setzt wohl Crowdstrike ein.

Ich bin es gerade am auseinander dividieren – es sind wohl zwei separate Ereignisse – bei M365 heißt es „Konfigurationsänderung an Azure“ ist verantwortlich.

ad 2) MS nutzt bei MS365 womöglich Crowdstrike?

Das war auch mein Gedanke – ist aber unzutreffend. Will noch was separat drüber schreiben.

Hat diese Software überhaupt jemals irgendwen vor irgendwas geschützt?

Hat da jemand was in der Quarantäne oder in den logs?

Wenn ja, wie oft?

Ich halte diese Art von Software für unnützes Schlangenöl, das bestenfalls nur die Angriffsfläche vergrößert.

Ein sicheres System hat eine möglichst kleine Angriffsfläche, besteht also nur aus dem allernötigsten, wie Dateisystem und Kernel.

In etwa sowas wie openSUSE MicroOS oder Arch Linux (EndeavourOS, Minimalinstallation) oder Fedora Silverblue.

Die eigentliche Software sollte in Containern laufen.

Dann hat man ein unmutubale Betriebssystem, das auch dann weiterläuft, wenn einer der Container befallen sein sollte.

Windows hat eine riesige Angriffsfläche durch die Unmenge an eigentlich unnötigen dll, Dienste und Frameworks.

Durch die unnötige App-Bloatware wird es noch schlimmer.

Oben drauf dann noch dieses Schlangenöl, das Sicherheit nur vortäuscht.

Und wieder wiederholt sich die Geschichte…

3rd party Sicherheitssoftware auf den Client-PCs sorgt für mehr Ausfallzeiten als die Bedrohungen, vor denen sie schützen sollen, es jemals schaffen würden. Bei uns sind solche Produkte, sobald sie so tief ins System eingreifen (meines Wissens läuft Falcon im Kernel Mode) sowieso tabu.

Mein Beileid an alle, die BitLocker verwenden, ihre Recovery-Keys im AD gespeichert haben und auch die DCs mit CrowdStrike „abgesichert“ und ggf. BitLocker verschlüsselt haben.

Das dürfte ein langes Wochenende werden…

„Mein Beileid an alle, die BitLocker verwenden, ihre Recovery-Keys im AD gespeichert haben und auch die DCs mit CrowdStrike „abgesichert“ und ggf. BitLocker verschlüsselt haben“

Dann wird man wohl ein Backup einspielen und die Keys dort auslesen, sofern man noch auf den Backupserver Zugriff hat…

come on, wer verschlüsselt den Server der den Backup Schlüssel hat oder von diesem den Backupschlüssel wo anders (zB auf Papier im Tresor) zu haben.

Hier™ wird noch on premises gearbeitet. Und ich bin einmal mehr glücklich darüber, hatte ich doch einen ganz normalen Arbeitstag. Ohne Ausfälle, dafür aber mit den Routineaufgaben, die hier so täglich anstehen.

Und nutzt Ihr on-premise Produkte von crowdstrike, nein?

Warum solltet ihr dann betroffen sein.

Wir arbeiten on-premise (ohne crowdstrike) nutzen aber auch „die“ Cloud u.A. auch MS365 und hatten heute KEINERLEI Probleme, huch und jetzt?

Wer es immer noch nicht verstanden hat, das ist kein originäres „cloud“ Problem gewesen!

und falls jetzt jemand kommt das Crowdstrike Update hätte man ja von einem Cloudserver runtergeladen…

Das wäre auch ganz ohne Could passiert wenn man in seiner on-premise Umgebung sowas per Akustikkoppler aus der Crowdstike BBS geladen hätte

Dieses Disaster spielt MS mal wieder zu 100% in die Karten. MS hat schon vor einiger Zeit die Aussage getroffen, das Dritthersteller den Systemschutz gar nicht so leisten können, wie der Hersteller (MS) der Software (Windows) selbst und ein Problem für Sicherheit und Stabilität sind.

CrowdStrike hat sich nun in die Reihe der Hersteller eingereiht, die es erfolgreich geschafft haben ein System für den User erstmal unbenutzbar zu machen, durch ein einfaches Update das im Hintergrund lief.

Somit darf sich CrowdStrike in die Liste zu Avast, Symantec, Avira, Kaspersky, Panda gesellen.

Sop-Hos (Sophos) nicht vergessen.

Die Aussage von MS kann ich sogar nachvollziehen, die kennen ihre Treiber APIs am besten. Es ist nicht nur unter Windows ein Problem wenn Drittsoftware im Kernel Kontext rumspielt, wenn es dann zu einem Fehler kommt, dann ist ganz gerne mal das komplette System weg.

„Ich kannte sogar die URL des Support-Beitrags, kam aber nicht weiter, weil das nur mit Anmeldung abrufbar war.“

Was ist das eigentlich für ein Unding, dass man sich überall anmelden muss, um einfachste Informationen oder Updates zu bekommen?

Bugmenot ist da übrigens oft auch hilfreich und stellt Logins für viele Webseiten zur Verfügung.

Gibt auch entsprechende Browser Addons:

https://chromewebstore.google.com/detail/dontbugme/mknlnngolpglmlcadgdmlaokbfgppmma?pli=1

Das wird wie bei SAP sein – ohne Registrierung und Nachweis einer Lizenz kriegst Du dort so gut wie keine Infos und Downloads, selbst wenn Du als nicht-SAP-Entwickler nur den C#-Connector (BTW immer noch nicht .NET Core faehig) brauchst um auf eine SAP-Kiste zuzugreifen…

Ich finds cool. Bitte mehr davon :-) Es muss aber noch mehr beim „Endverbraucher“ ankommen. Damit Volkes Seele kocht. Ohne Mistgabeln und Fackeln werden die „Entscheider“ nicht lernen.

Es ist ja nicht nur Azure Cloud betroffen, auch AWS und Google Cloud. Die laufen aber m.W. auf Linux. Wie kommt das?

selbst schuld und kein mitleid. nicht crowdstrike oder welcher cloud anbieter auch immer sind schuld am debakel, sondern die manager und entscheider, die den dreck kaufen und sich bug für bug aufdrücken lassen. mit cloud ist das halt so. onpremise bei solchen katastrophen war der admin nur kurz admin im unternehmen.

https://www.crowdstrike.com/en-us/ und da lese ich

Unified platform. One agent. Complete protection.

CrowdStrike Falcon: Cybersecurity’s AI-native platform.

Damit ist alles gesagt. Wer das einsetzt verdient es nicht anders.

insofern wer so dämlich ist und solchen dreck kauf und bug für bug und versagen für versagen des herstellers hinnimmt, verdient es nicht anders.

Sie sind ein Held.

Ein weiterer Workaround aus dem Heise Forum:

In der Crowdstrike Console beim Deploy die Sensor Version auf 11 stellen

Alle Server und Clients Rebooten…

die korrekte Lösung: Crowdstrike von allen Geräten entfernen.

Glaube nicht das dies geht. Mit Bitlocker wohl nicht. Das System muss zuerst gestartet werden können und ans Netz.

Siehe die Antwort von Ralf unten.

Gerade mal geistig durchgespielt was passiert, wenn auf dem System Bitlocker aktiv ist und im BIOS/UEFI external boot deaktiviert wurde.

1. BIOS/UEFI Kennwort herausfinden

2. Bootreihenfolge umstellen bzw. external Boot aktivieren.

3. Hoffen das der Bitlocker-Key per Policy oder extern gesichtert wurde.

4. Boot von externem Datenträger und Eingabe des 48 stelligen Keys

5. Fehlerhafte Datei oder Verzeichnis umbenennen

6. Neustart und Daumen drücken.

Da vergeht schon einiges an Zeit bis das System wieder läuft.

Nein, alles was man braucht ist ein Rescuemedium mit Bitlockerunterstützung (kann auf USB sein, z.B. ein ISO unter Ventoy) und den recovery key in einem *.txt auf einem 2. USB.

1) boot von RM

2) manage-bde -unlock c: -recoverypassword [recovery key]

3) Fehlerhafte Datei oder Verzeichnis umbenennen

Den recoverykey fügt man per copy&paste vom 2. Medium ein.

Die professionelle IT übt das vorher ein paar Mal, dann dauert so etwas 5, max. 10 Minuten. Ja, wirklich, ich brauche jedenfalls nicht länger und mache das (rescue starten, Bitlocker-laufwerk aufmachen) nur 1-2 Mal im Jahr.

In grösseren Umgebungen könnte ein iPXE-basiertes* Rescuesystem noch mehr Zeit sparen.

* z.B. netboot .xyz <– Webseite, Leerzeichen entfernen

Im letzten Artikel, der am Beitragsende verlinkt ist, habe ich inzwischen einen Post veröffentlicht, wo jemand 5.000 Maschinen hat. Da geht beim Üben die Puste aus – und wenn die Maschinen weltweit stehen, wird es schwierig, es sei denn, es gibt noch einen Trick, den ich kenne.

Naja, das Üben war vorher, es sind dann, ohne Wegezeiten, schon 3+ Mannminuten pro Maschine (wenn man parallel arbeiten kann, während A bootet unlocked man B und startet ein Batch).

Ohne die immer verschiedenen Bitlockerkeys könnte man es mit wenig Aufwand noch weiter automatisieren.

Mir hing es auch primär darum, aufzuzeigen, dass es pro Maschine kein sooo grosser Zeitaufwand ist, dass der Aufwand, nicht-automatisierbare Aufgaben auszuführen, mit der Anzahl der Maschinen skaliert, ist aber nun wirklich eine Binse.

Gibt es denn keine Update Ringe / Stage/dev/Test Umgebungen mehr? Zu meiner Zeit wurden AV pattern auch auf die Hauptmasse paar Stunden verzögert installiert…

Disk einer Cloud gehosteten VM un/mounten ist schon heftig und zeitintensiv. Vieleicht gibt es ja bald dafür mal console Access als Saas oder PowerAutomate Addons…

1.) Cowdstrike hat fehlerhafte Updates ausgeliefert

Das ist korrekt.

2.) Microsoft hat wiedermal Mist bei M365 gebaut

Microsoft setzt wohl Crowdstrike bei M365 ein.

Oder betrifft das Crowdstrike Problem auch direkt Microsoft?

Ja, denn MS setzt wohl Crowdstrike ein.

Die Autofreien Sonntage der 70er Jahre kommen wieder , in neuer Erscheinungsform und zeitlich per Zufall ;-)

Eine Anmerkung zum Thema „vorher Testen“. Schaut euch mal alle Folgen von „Maday“ an. Die Flugindustrie „testet“ ihre Produkte auch im praktischen Arbeitseinsatz. Und bei Mayday wird über so manche Absturz-Ursache berichtet, an die man durchaus vorher hätte denken können … bzw. auch MÜSSEN. Doch manchmal, hilft alles testen nichts, weil manches noch nicht hinreichend erforscht und vorhersagbar ist, sei es das Wetter, Materialeigenschaften bis hin zu scheinbar simplen physikalischen Zusammenhängen (wann und wie gefriert Wasser) oder Arbeitsabläufe, die dann doch nicht so funktionieren wie sie sollen. Bis hin zu Sprachbarrieren und die unvorhersagbare Tagesform und generell die Eigenschaften von Menschen (Piloten, Luftfahrt-Techniker etc.). Da machen halt auch Leute mit 20.000 Flugstunden unerwartet doch „Anfänger“-Fehler und reagieren nicht wie gewohnt, eingeübt und erforderlich…

Heute gab es noch eine „Nachricht“, man wolle die Fehleranfälligkeit von KI besser ergründen … Da wünsche ich mal viel Spaß, so lange man nicht bedenkt, dass das was man bislang fälschlich als KI bezeichnet eigentlich nur von Menschen gemachte Algorithmen sind … und da sind sie wieder, die von Menschen mit Einprogrammierten Fehler, Vorurteile, Vorlieben, Meinungen … die sich vielleicht erst nach Jahren unerwartet offenbaren…

Fazit: durch Testen man kann vieles optimieren und die dümmsten Fehler vermeiden. Aber es lassen sich nie alle denkbaren Betriebsbedingungen vorab simulieren … Testen kostet außerdem, was die Produkte verteuert. Aus diesem Grunde ist Raumfahrt so unfassbar teuer, weil man dort weit überdurchschnittlich viel Testet und Testen muss …

Auch in unserem Betrieb war die cloudbasierte Software lahmgelegt: rien ne vas plus. Was ich nicht verstehe: in der Qualitätskontrolle kann man nicht alle noch so exotisch konfigurierten Kundensysteme abdecken: o.k. Wenn aber weltweit tausende Systeme von Großkunden lahmgelegt werden, so MUSS das bei einer vernünftig organisierten Qualitätskontrolle schon im Vorfeld detektiert werden. Und zwar bei Crowdstrike. Oder werden da in sicherheitskritischen Bereichen etwa Updates ohne jedwede Qualitätskontrolle einfach so ‚rausgehauen‘? Banana-Software at its best?

Eine wilde und sicherlich haltlose Spekulation:

Crowdstrike verteilt seine Updates über die MS-Cloud und deren Fehlkonfiguration führte dazu, daß kaputte bzw. unvollständige Updates ausgeliefert wurden.

Die Dateien C-00000291*.sys enthalten nur Nullen.

Das ist kein Treiber und es sind keine Signaturen.

Jeremy Howard auf X:

Wtf? The CrowdStrike file that broke everything was entirely full of null characters. How does this happen?

christian_taillon:

You’re correct.

Full of zeros at least.

x[.]com/jeremyphoward/status/1814364640127922499

Wie erzeugt man denn eine sys-Datei, die nur aus Nullen besteht, mit dem normalen Prozess, der sonst diese Treiber oder Signatgurdateien erzeugt hat?

Sowas kann nicht von einem Compiler erzeugt werden.

Eine Signaturdatei müsste auch die bisherigen Signaturen enthalten und neue Signaturen würden lediglich hinzugefügt.

Warum versucht Windows so eine Datei auszuführen, wenn im Dateiheader keine Kennung für eine ausführbare dll enthalten ist?

Nur zur Ergänzung für Mitleser – ich habe am Artikelende in einem Link auf einen Folgebeitrag mit einer Analyse verwiesen, warum es zum fatalen Fehler kam.

„Crowdstrike Analysis:

It was a NULL pointer from the memory unsafe C++ language.

Since I am a professional C++ programmer, let me decode this stack trace dump for you“…

Ganzer Thread hier: https://x.com/Perpetualmaniac/status/1814376668095754753

Wenn ich die Analyse richtig gelesen habe, verweist der ‚Treiber‘ auf eine Memory-Adresse, ‚wo das Programm nichts zu suchen hat‘. Und Windows killt so einen Prozess sofort, was zum Absturz führt. Anders gesagt: ein ganz massiver Programmierfehler. Und wieder stellt sich die Frage, wie eine Firma, die nicht im Endverbrauchermarkt tätig ist, sondern hochpreisige Sicherheitspakete an Großkunden in systemkritischen Bereichen verkauft (und somit zu besonderer Sorgfalt verpflichtet ist) , so einen systemnahen ‚Treiber‘ anscheinend ohne nähere Prüfung (da muss so etwas auffallen) in Verkehr bringt. Ist so etwas nicht grob fahrlässig? Auf jeden Fall wird sich die Firma wohl in den USA milliardenschweren Klagen stellen müssen. Da könnte das Gericht unangenehme Fragen an das Management stellen.

Gegen 7:00 früh hat sich bei mir auf Arbeit der Windows 10 PC neugestartet. Danach hing er in einer Endlosbootschleife.

Der Dialog zur Systemwiederherstellung kam nicht. Als Ursache wurde die Datei „csagent.sys“ angezeigt.

Habe mich dann nicht weiter mit dem Problem beschäftigt, da ich den PC für die Arbeitstätigkeit nicht zwingend brauchte.

Windows 7 Clients hat das Problem nicht betroffen. Die haben nur die Netzwerkverbindung zu den Betriebseigenen Servern verloren. Nachdem die IT diese wieder zum laufen gebracht hatte, konnte man über Windows 7 Clients normal weiter arbeiten.

Bleibt für mich als Nutzer nur eine Frage offen.

Weshalb haben verschiedene Windows 10 Clients nicht den Wiederherstellungsdialog geladen. Andere wiederum haben das automatisch gemacht.

Bei weiteren Clients (später am Tag) hat es geholfen den Netzstecker zu ziehen. Anschließend sind die dann wieder gestartet.

man kann die Reaktion auf einen BSOD einstellen.

neu Boot oder einfrieren

großer Memory dump (swap file 1,5 x RAM…)

kleiner Memorycdump (selten wirklich hilfreich, aber schnell und und zumindest etwas wenn die Mähre ständig abschmiert.

Eintrag in Eventlog..(naja,Statistik)

ganz grosse Künstler schaffen es, das WinRE komplett wegzuoptimieren um ein paar GB Platte einzusparen.

Und so kommt es wohl zu dem was Du fragst

HTH?