[English]Das Supportende von Windows 10 kommt im Oktober 2025. Daher sind wir nun wieder beim beliebten Spiel Microsofts, dass Nutzer von Windows 10 „Werbung“ als Vollbildanzeige zu sehen bekommen, was für tolle Alternativen es von Microsoft doch gibt. Aber noch gibt es wohl nicht die Vollbildanzeigen, dass Windows 10 aus dem Support fällt und man wechseln soll.

[English]Das Supportende von Windows 10 kommt im Oktober 2025. Daher sind wir nun wieder beim beliebten Spiel Microsofts, dass Nutzer von Windows 10 „Werbung“ als Vollbildanzeige zu sehen bekommen, was für tolle Alternativen es von Microsoft doch gibt. Aber noch gibt es wohl nicht die Vollbildanzeigen, dass Windows 10 aus dem Support fällt und man wechseln soll.

Anfang des Jahres hatte ich im Blog-Beitrag Windows 10: Microsoft zeigt neues Nerv-Popup zum Upgrade auf Windows 11 bereits erwähnt, dass Microsoft sogenannte „Nag-Screens“ bei Benutzern anzeigt, die zum Upgrade auf Windows 11 auffordern. Der Hintergrund ist, dass einmal der Support von Windows 10 für die meisten Benutzer im Oktober 2024 ausläuft. Andererseits dümpelt Windows 11 in der Nutzergunst doch arg bescheiden herum. Irgendwie ist es langsam an der Zeit, den Nutzern von Windows 10 „Beine zum Umstieg zu machen“.

Aktuell scheint das Microsoft-Marketing aber subtilere Methoden zu verfolgen, um Windows 10-Nutzern dieses Windows 11 näher zu bringen. Die Kollegen von neowin.net haben das Thema im Beitrag hier aufgegriffen und schreiben, dass mehr Nutzer jetzt irgendwie mit Vollbild-Anzeigen traktiert werden.

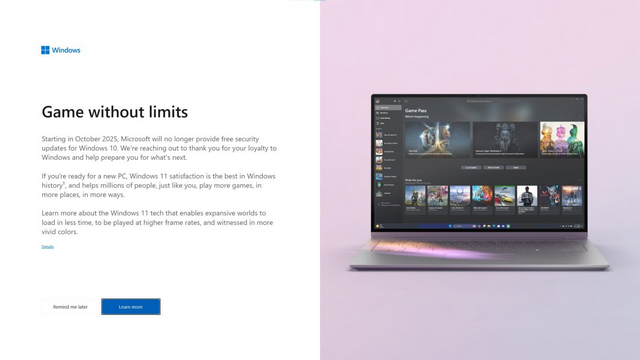

Es wird auf den ArsTechnica-Beitrag Microsoft pushes full-screen ads for Copilot+ PCs on Windows 10 users verlinkt, in dem Vollbild-Werbeanzeigen, die Nutzern Copilot-PCs mit Windows 11 schmackhaft machen sollen, thematisiert wurden (Tomas Jakobs hatte es auch im Diskussionsbereich verlinkt, danke – war mir aber wieder entschlüpft).

In obigem Screenshot wird auf das Supportende von Windows 10 und den Nachfolger Windows 11 hingewiesen. Eine Schaltfläche zum Ablehnen gibt es wohl nicht – der klassische Ansatz von Microsoft, die Leute zu traktieren.

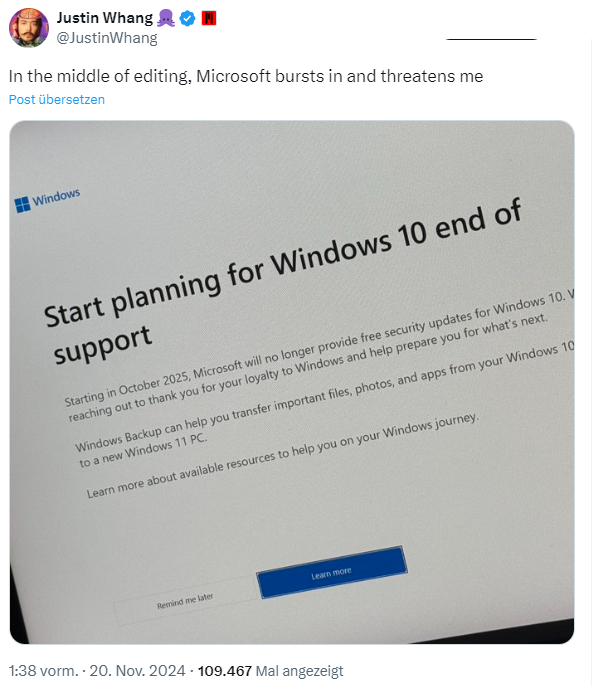

Neowin.net verweist auf weitere Social-Media-Posts wie obigen Tweet von Justin Whang, der eine Werbung für Windows Backup samt dem Hinweis auf das Supportende von Windows 10 als Vollscreen beim Arbeiten erhalten hat und entsprechend angepisst war. Neowin.net führt weitere Posts, wie diesen Tweet auf, wo mit „Windows 11 do more“ auf die Nutzer eingewirkt werden soll. Auch dieser Post zitiert einen Nerv-Vollscreen-Popup, in dem auf das Windows 10-Supportende verwiesen wird.

Müßig zu erwähnen, dass es selbst für Privatanwender eine Supportverlängerung für Windows 10 um ein Jahr für 30 US Dollar gibt (siehe auch meinen Artikel Windows 10: Überraschung, es gibt ESU-Supportverlängerung; auch für Privatanwender sowie den Beitrag Microsoft will 30 US-$ für 1 Jahr Windows 10-Supportverlängerung).

Hat jemand aus der Leserschaft inzwischen auch solche Anzeigen zu sehen bekommen? Bei meinem Windows 10 2019 IoT Enterprise LTSC wird es so etwas nicht geben – und auch das Notebook mit Linux Mint 22 muckt diesbezüglich nicht.

Artikelreihe:

Windows: Microsofts Bing-Wallpaper als „Adware“? – Teil I

Windows 10-Supportende: Mehr Nutzer bekommen Nag-Screens gezeigt – Teil II

Ähnliche Artikel:

Windows 10: Microsoft zeigt neues Nerv-Popup zum Upgrade auf Windows 11

Windows 10 V1903/1909 zeigt Nag-Screen ‘Ziehen Sie ein …’

Windows 10 V1909: Neuer Willkommen Nag-Screen (Mai 2020)

Edge nervt seit Version 125 mit Full-Screen-Popups

beim vergangenen Linux Presentation Day waren mehrere Besucher, die ebenfalls innerhalb von Windows 10 den Hinweis erhalten haben. Das war der Grund für deren Besuch und sich mal mit Linux zu beschäftigen.

Wenn die Besucher sich denn dann wirklich damit beschäftigen, anstatt es nur zu installieren und zu erwarten, „es ist dann ja so einfach wie Windows“, ist es durchaus lobenswert.

Installieren sich jedoch noch mehr Unerfahrene eine Linux-Distri und verweigern es, sich damit zu beschäftigen, dann ist es eher uncool und könnte gefährlich werden.

Das gute an dem Windows 11 „Zwang“ und den Gängelungen von Microsoft (z.B. Zugang nur noch mit Microsoft Account) ist, es finden immer mehr Menschen den Weg zu Linux. Innerhalb eines Jahres hat sich die Benutzeranzahl von 2 auf 4% verdoppelt, Tendenz steigend.

Freut mich wirklich sehr, da irgendwann auch Software-Firmen anfangen werden, extra Versionen für Linux auf den Markt zu werfen. Dank Valve/Steam und Heroic ist es jetzt schon möglich, fast 90% der Games auf Linux ohne größere Probleme zu spielen.

Ich plane da noch zwei Beiträge in Sachen „Lösen vom Lock-In“ und „Wo Linux Sinn macht“. Ich befasse mich seit 1993 am Rande mit Linux, mal intensiver mal weniger. Ich formuliere es mal so: Apple hat mit macOS gezeigt, wie man eine weitgehend konsistente GUI auf einen Mach-Kernel setzt, so dass die meisten Anwender sehr gut mit klar kommen („it simply works“ – goldener Käfig „Apple“ thematisiere ich mal nicht). Und Microsoft hat mit Windows – so viel ich hier im Blog auch kritisiere – ein Eco-System geschaffen, was für die Masse der Leute einfach funktioniert. Und jeder Android-Nutzer sitzt auf einem Android-Kernel, wo es mit der GUI läuft – ähnliches gilt für Navis oder viele IoT-Geräte.

Aber es geht beim Desktop beim Schlagwort „Linux“ leider um Linux-Distributionen (Ubuntu, Fedora, OpenSuse, Mint, Debian etc.). Bei den Linux-Distributionen erlebe ich die letzten 30 Jahre ein Desaster nach dem anderen, wenn Du mal etwas mehr als Firefox und Thunderbird nutzen willst. Es gab mal Bücher zu Linux (damals SuSE) von mir, die ich wegen mangelnder Nachfrage und zu schnellem Produktwechsel nach der 3. Auflage einstellen musste (gut, kurz danach hat die damalige S.U.S.E die Grätsche gemacht). Dann gab es zwei Bücher zu den ersten Netbooks (eeePC …), die auf Linux basierten – für Nutzer war es ein Drama, wenn sie mehr als mit dem Gerät geliefert machen wollten. Ende vom Lied: Die haben sich Windows XP drauf gezerrt. Abstimmung mit den Füßen. Joke am Rande: Meine ersten Beiträge im Vista-Blog drehen sich um genau „dieses Linux“ auf Netbooks.

Ich habe gerade einige Mint 22-Erfahrungen hinter mir – wo ich aus dem recherchieren nicht heraus kam, weil ich Probleme mit KVM und Windows 10 hatte, NTFS-Volumes wegen eines Bugs nicht gemountet werden konnten etc. Virtualbox bekomme ich nicht zum Laufen, weil der Virtualisierungstreiber im Kernel nicht geladen werden kann – Lösung habe ich noch keine. Man sollte also vieles nüchtern sehen – auch wenn mir oft der Kamm schwillt, wenn ich sehe, wie das Microsoft-Produkt-Marketing die Sachen verhunzt.

Bin gespannt auf Ihre Beiträge.

Ich war mit Windows 7 sehr zufrieden, habe aber nach dem Erscheinen von Windows 10 begonnen, mich mit Linux zu beschäftigen, weil ich den Eindruck hatte, dass sich Windows und Microsoft in eine Richtung entwickeln, die mir nicht gefällt. Was sich inzwischen mehr als bestätigt hat.

Meine Erfahrungen mit Linux (Mint Mate 19 -> 20 -> 21 auf der Workstation; Mint Mate 22 auf dem > 16 Jahre alten Laptop mit 4GB RAM) sind eigentlich durchwegs positiv. Insbesondere läuft auch VirtualBox (6.0 -> 6.1 -> 7.0) ohne Probleme, sowohl Host- wie auch Guest-seitig, und meine Daten sind aus Kompatibilitätsgründen auf NTFS-Partitionen, was auch einwandfrei und ohne irgendwelche Klimmzüge funktioniert (hilft Ihnen nicht, ist mir klar).

Besonders beeindruckt bin ich nach wie vor davon, dass man Drucker/Scanner nicht mehr aufwendig installieren muss. Netzwerkstecker rein, fertig, funktioniert.

Dank diverser nützlicher OpenSource-Projekte sowie ein bisschen bash-Scripting sind mir inzwischen sogar Dinge gelungen wie meine Kameras über WLAN mit dem PC kommunizieren zu lassen (denn die Kamera-Hersteller-Software läuft natürlich nicht unter Linux) oder Daten mit dem iPhone auszutauschen bzw. ein Backup vom iPhone zu machen. Das grottige iTunes in der Windows-VM hat damit endlich ausgedient…

MATE kann leider keine brauchbare Skalierung, genausowenig wie XFCE oder Cinnamon.

Für Laptop-Bildschirme reicht es noch aus, aber für große HiDPI Bildschirme ist das nicht mehr brauchbar.

Da ist KDE Plasma das beste, weil es eine sehr feine nahezu stufenlose Skalierung erlaubt und ein perfektes Schriftbild erzeugt. Das funktioniert besser als im neuesten Windows.

Wenn man von Windows kommt, dann ist Linux wie ein OS mit Kindersicherung. :) Meinen Eltern habe ich vor vielen Jahren den Win2k-PC auf Ubuntu LTS umgestellt. Läuft soweit ohne große Probleme. Nur beim Upgrade auf 24.04 LTS neulich gab es Stress mit dem Einfrieren des Desktops. Liegt an einer neu dazugekommenen Inkompatibilität zwischen Treiber und integrierter Grafik einer alten Intel-CPU. Eine PCIe-Grafikkarte aus der Schublade löste das Problem. Vom Admin-Blickpunkt aus gesehen, lassen sich viele Probleme unter Linux deutlich leichter debuggen und lösen.

Es ist leider der weit verbreitete Irrglaube in der Linux-Anhängerschaft, dass man unter der Haube mit „deutlich leichter debuggen und Probleme lösen“ die Masse der Nutzer hinter den Ofen hervor locken könne. Hart ausgedrückt: Mit einem Betriebssystem will die Masse schlicht arbeiten. Ein simples Beispiel: In Windows will ich ein Virtualbox (oder eine andere Anwendung) einsetzen. Den Installer herunterladen und wenn die nicht gepatzt haben, reicht ein Doppelklick auf die .exe-Datei, um im Installer den Prozess zu durchlaufen und danach arbeiten zu können.

Bei Mint musste ich mir zur KVM-Installation auf Konsolenebene zig Komponenten installieren – weil es wohl keinen Paketmanager gibt (oder ich habe den nicht gefunden), und eine Reihe Konfigurierschritte ausführen. Ich habe zig Installationsanleitungen mit leicht unterschiedlichen Ansätzen im Internet gefunden. Als ich in einem Windows 10-Gast in der VM kein Netzwerk bekam, durfte ich anfangen zu recherchieren, wo es dran krankt. Wie erwähnt, Virtualbox läuft aus den Repositories überhaupt nicht, weil der Virtualisierungstreiber im Kernel nicht geladen werden kann. Bisher keinen Plan, wo es dran krankt. Kann man alles hin bekommen – über so etwas habe ich mir unter Windows nie Gedanken machen müssen.

Das kann und will sich kein normaler Anwender antun – oft fehlen Zeit und Erfahrung. Hat nichts mit „OS mit Kindersicherung“ zu tun, sondern damit, dass eine einheitliche Klammer für eine GUI samt „Software-Management“ über diverse Distributionen fehlt. In OpenSuse verwende ich erinnerungsmäßig yast zur Paketverwaltung – in Debian kommt apt zum Einsatz usw. Linux ist Anarchie der Beteiligten – Windows ist Terror des MS Marketing – und Apple ist goldener Käfig. Pest und Cholera – man kann wählen. Vielleicht werde ich auch zu alt für den Mist – aber die Nutzer stimmen schlicht mit den Füßen ab – da können wir in unserer Tech-Bubble jammern oder ranten wie wir wollen.

“ In Windows will ich ein Virtualbox (oder eine andere Anwendung) einsetzen. Den Installer herunterladen und wenn die nicht gepatzt haben, reicht ein Doppelklick auf die .exe-Datei, um im Installer den Prozess zu durchlaufen und danach arbeiten zu können.“

Und in Linux, z.B. Ubuntu im jeweiligen Software Center VirtualBox suchen, installieren klicken, Kennwort eingeben, fertig. Ist nicht viel anders.

Ich schaue nochmals – aber in Mint 22 ist mir genau das nicht aufgefallen – war das erste, nachdem ich (in diversen Installationen) gesucht habe.

Ergänzung: Ich habe nur die Anwendungsverwaltung (für meine Zwecke unbrauchbar) und synaptic als grafischen Paketmanager – an dem ich mit Virtualbox gescheitert bin – KVM habe ich über die Konsole manuell installiert und eingerichtet.

Zum VirtualBox-Problem (bin da aber wirklich nicht der Experte): Ist an dem Host Secure Boot eingeschaltet? Falls ja, mal ohne probieren. Falls das das Problem war, müssen VirtualBox-Komponenten signiert werden. Bei einer Neuinstallation von VirtualBox 7 wird man da eigentlich durch den Prozess geführt. Geht aber auch manuell.

Wie von Stefan erwähnt: Software-Manager. GUI-Paket-Manager ist Synaptic. Beide finden sich bei Mint Mate in der Default-Einstellung links im Startmenü (aus dem Gedächtnis; arbeite gerade mit Win 10).

Alternativ, insbesondere wenn man (wie ich) nicht von den Repositories abhängig sein möchte: .deb-Datei herunterladen, Doppelklick. Also wie mit der .exe in Windows. Oder, falls keine .deb-Datei angeboten wird (aber für VirtualBox gibt’s die), das Binary-Archiv herunterladen und z.B. nach /opt entpacken.

Ist natürlich nicht 100% identisch mit Windows, klar. Ist ja nicht Windows. Aber genauso einfach. Finde ich.

Günter, da ist gerade so viel falsch, was Du geschrieben hast:

> Bei Mint musste ich mir zur KVM-Installation auf Konsolenebene zig Komponenten installieren – weil es wohl keinen Paketmanager gibt (oder ich habe den nicht gefunden), und eine Reihe Konfigurierschritte ausführen.

Du vergleichst Virtualbox mit KVM, warum? Füge Dir die Repositories von Virtualbox hinzu und installier diese mit dem Paketmanager, der natürlich in jedem Debian Linux (und dessen Derivate Ubuntu, Mint etc.) enthalten ist.

Die notwendigen Netzwerksetup machst Du in /etc/init.d/vboxdrv setup, die Kernelmodule bekommst Du mit apt install virtualbox-dkms*

KVM wäre eher vergleichbar mit HyperV und da wirst Du bei Windows genauso mit unterschiedlichen Rollen, virtuellen Switchen und (Unter-)Komponenten jonglieren müssen.

Weißt Du was das gute an Linux ist? Es versucht Dir keine Steine in den Weg zu legen, Du kannst das alles in den Manuals und Anleitungen nachlesen:

https://wiki.debian.org/VirtualBox#Installation

Und again, der Tipp. Halte Dich am Original Debian und nicht an irgendwelchen Derivaten, die Ihr eigenes Zeug machen.

Ich habe Verständnis dafür, dass angestauter Frust ab und zu raus muss. Aber man sollte dies aber nicht als anekdotische Evidenz auf die Allgemeinheit übertragen. Z.B. hatte ich bisher noch keine wirklichen Probleme mit VirtualBox unter Linux. Vor ein paar Jahren bin ich nach einem VirtualBox-Update über ein Soundproblem gestolpert, das über eine Konfigurationsänderung umgangen werden kann. Dies hilft dir jetzt nicht weiter, soll aber verdeutlichen, dass es auch einfach laufen kann. Und auch umgekehrt, und alles dazwischen. Frage mich mal wie oft ich schon Probleme mit Software unter Windows und Windows selber hatte.

„Mit einem Betriebssystem will die Masse schlicht arbeiten.“

—

Wie wäre es dann mit OpenSUSE AEON (GNOME) oder Kalpa (KDE Plasma)?

Das läuft auf einem schreibgeschützten unmutable MicroOS und alle Programme sind in flatpaks.

Alternativ Fedora Silverblue (GNOME) oder Kinoite (KDE Plasma), ebenfalls schreibgeschützt unmutable mit flatpaks.

Sowas bekommt ein normaler Anwender nicht kaputt.

Updates laufen automatisch im Hintergrund ohne Benutzereingabe, aber die werden auf die andere Partition geschrieben und beim nächsten Booten umgeswitcht (A-B), ohne dass der Benutzer davon etwas merkt.

Inzwischen gibt es jetzt seit wenigen Tagen mit Kernel 6.12 sogar RealTime Fähigkeit in Linux, wenn man das haben möchte und man kann sogar die Scheduler austauschen und für spezielle Zwecke optimieren (zB Borg-Scheduler für Spiele).

Das NTFS-Problem ist bei openSUSE schon seit Jahren behoben und KVM-Tools oder XEN-Tools sind auch auf Knopfdruck im Yast da.

Andere Distributionen benutzen den neuen fehlerhaften experimentellen „NTFS3″-Treiber, während der alte stabile NTFS-3G“-Treiber für NTFS tadellos funktioniert.

Also einfach die 3G-Version statt die 3-Version nehmen und alles ist OK.

„Aber Word geht nicht“

@Anonymous sagt:

21. November 2024 um 13:22 Uhr

Dafür ist Virtualisierung bestens geeignet – WINDOWS-Client unter LINUX-Host funktioniert einwandfrei.

[QUOTE]

…Andere Distributionen benutzen den neuen fehlerhaften experimentellen „NTFS3″-Treiber, während der alte stabile NTFS-3G“-Treiber für NTFS tadellos funktioniert.

Also einfach die 3G-Version statt die 3-Version nehmen und alles ist OK.

[/QUOTE]

Wenn man mit maximal 30 MB/s Datendurchsatz zufrieden ist, kann man natürlich den auf FUSE aufbauenden ntfs-3g-Treiber weiterhin nutzen.

Aber ich muß auch dazu schreiben, daß seit neuestem bei mir ein ntfs3-Modul immer mal wieder ein NTFS-Laufwerk nicht von vornherein in der fstab einbinden läßt, warum auch immer?!?

Ich spiele durchaus mit dem Gedanken an openSUSE – da ich da Yast noch kenne. Nur hüpfe ich da nicht so einfach drauf, ohne zu wissen, ob mein Dell Notebook, welches mir mit Mint 22 bereitgestellt wurde, beim Distributionswechsel sofort und ohne Klimmzüge funktioniert.

Aktuell kann ich daher nur wiedergeben, was ich unter dieser Maschine erlebe. Unabhängig davon habe ich in den letzten 12 Monaten immer wieder in virtuellen Maschinen Mint installiert gehabt und dort geschaut, ob ich KVM etc. auf die Schnelle wenigstens in einem Paketmanager auswählen kann. Fehlanzeige.

Dass das NTFS-Problem unter openSUSE seit Jahren behoben ist, nutzt mir nix, wenn ich auf einem Mint 22 mal auf die Schnelle eine USB-Festplatte mit NTFS-Partitionen mounten will, um ein Thunderbird-Profil zu importieren, dass OS mir aber mitteilt, dass es die Partition nicht lesen kann. Habe es dann zwar gelöst, aber das ist Murks. Kann mit Mint zusammen hängen – kann es nicht beurteilen.

@TomasJakobs: Ich vergleiche nicht KVM mit Virtualbox – sind die zwei Virtualisierungslösungen, die ich mal schnell testen wollte. Hyper-V habe ich unter meinem Windows 10 Pro mit zwei Mausklicks arbeitsfähig eingerichtet. Dass ich dann Switches etc. konfigurieren muss, ist klar.

@All: Was der Kommentar verdeutlichen sollte: Ich kann mir eine Linux-Distribution installieren – und wenn ich mit dem Standardumfang zufrieden bin, ist das super. Sobald ich aber mehr möchte, kann es schwierig werden. Die Mint 22-Anwendungsverwaltung erscheint mir ziemlich unbrauchbar – synaptic als Paketverwaltung wirft mir ebenfalls zig Pakete zur Installation aus, wenn ich nach KVM oder Virtualbox suchen lasse. Ad-hoc weiß ich dann nicht, welche Pakete ich auswählen muss, um alle Abhängigkeiten aufzulösen. Und so geht das weiter – es ist alles machbar, aber ich habe etliche Stunden verbraten, um hinter Unwägbarkeiten hinterher zu recherchieren und in der Mint 22-Installation hinzubiegen. Ist etwas unbefriedigend – muss mal schauen, ob ich ein Backup der SSD anfertige und wirklich openSUSE oder Debian bzw. LMDE auf das Notebook installiere.

Neue SSD rein, neues Linux drauf. Falls es nicht mag, alte SSD wieder rein.

Und für ggf. Datentransfer der alten/neuen SSD einfachen einen USB3 SATA Adapter für maximal 10-15€ besorgen.

Könnte ich tun – wenn ich mir eine SSD im Handel hole – aber nochmal: Wir waren beim Thema „in Windows ist vieles einfach, aber das Marketing nervt – also nehme ich Linux und bin glücklich“ – und dann fange ich an, mit SSDs samt Schraubenzieher hinzulegen, um SSDs zu tauchen und zig Installationen zu probieren – really?

Ich muss mal sehen, ob ich ggf. nested virtualization aktiviert bekomme – dann könnte ich diverse Linux-Distributionen ein einer VM auf solche Fragestellungen wie „KVM oder Virtualbox installieren“ testen.

Unabhängig davon: Ich stelle hier mal die Kommentierung ein – es wird an der Stelle sinnfrei und wenig zielführend.

Warum: Ich plane ganz konkret in Artikeln zu beschreiben, wo ich bei bestimmten Sachen auf Klippen aufgelaufen bin. Dann kann da konkret diskutiert werden „das hättest Du so oder so lösen können“. Mit diesem Ansatz verlieren wir uns nicht im ungefähren (ich schätze durchaus eure Ratschläge, nur nutzen die nix, wenn ich auf einer anderen Plattfom sitze), andere Betroffene, die vielleicht die gleichen Probleme haben, finden ggf. eine Lösung und der Rest kann vielleicht was lernen. Win-Win-Situation für alle.

Ich habe jetzt seit Sommer Mint 22 Cinnamon auf dem Rechner (meine erste Linuxinstallation, vorher immer nur Windows) und kann mich nicht beklagen. Die Programme, die in den Paketquellen von Ubuntu/Mint drin sind, findet man mittels der Anwendungsverwaltung eigentlich problemlos. Einfach im Suchfeld den Namen eingeben und er zeigt alle Pakete an, die dazu passen. Falls es die Version als Systempaket und als Flatpak gibt wird beides angezeigt, wobei die Flatpaks als solche markiert sind. Wenn man installiert werden auch automatisch alle notwendigen Voraussetzungen mitinstalliert (man bekommt die Info, was er alles benötigt, aber man muss die nicht manuell suchen und installieren, das übernimmt die Anwendungsverwaltung automatisch). Installierte Programme werden mit einem Haken angezeigt bzw. man kann sich auch direkt nur alle installierten Programme anzeigen lassen. Bei anderen Programmen, die nicht in den Standardquellen drin sind (wie z.Bsp. dem Vivaldi Browser) habe ich mir das .deb von deren Webseite geladen und per Doppelklick installiert. Die von Vivaldi tragen in dem Zuge auch ihre Paketquellen mit ins System ein, so dass Updates wie bei Systempaketen direkt über die Aktualisierungsverwaltung kommen. Komplett ohne Konsole, alles per GUI. Klar, kann man natürlich auch über Terminal machen, muss man aber nicht.

Daher verstehe ich nicht so ganz, warum du meinst die Anwendungsverwaltung wäre unbrauchbar.

Klar, es ist Umgewöhnung, weil es halt anders ist, aber einmal dran gewöhnt klappt es ziemlich gut. Selbst viele Windows Programme funktionieren dank Wine/Proton wie gehabt, daher muss man je nachdem was man nutzt nicht mal auf die gewohnten Programme verzichten. Läuft natürlich nicht alles, aber doch schon viel.

Zu „Anwendungsverwaltung unbrauchbar“: Meine erste Idee war, die Anwendungsverwaltung aufzurufen, KVM oder Virtualbox anzuwählen und einrichten zu lassen. Wenn ich dort Begriffe wie Virtualbox oder KVM in der Anwendungsverwaltung eingebe, wird nichts gefunden – habe es eben nochmals geprüft. Sind wohl weder als Flatpak noch als sonstige Pakete zu finden. Damit war die Anwendungsverwaltung (die ich zuerst probiert hatte) in diesem Fall für meine Zwecke nicht brauchbar. Daher habe ich den synaptic Paketmanager aufgerufen, der mir die Pakete anzeigt – wo aber so viel weitere Einträge auftauchten, dass ich bei KVM auf die Konsole ausgewichen bin und genau das installieren ließ, was gemäß diversen Internetseiten gebraucht wurde.

Ich muss das Ganze jetzt aber mal genauer untersuchen. Gerade in einer VM ein älteres Linux Mint 18 gebootet, was dort noch installiert war. Dort ließ sich Quemu-KVM (und auch Virtualbox) problemlos finden – und die Anwendungsverwaltung stellt sich grafisch auch anders dar, so, wie ich sie in Erinnerung hatte. Möglicherweise ist die vorinstallierte Mint 22-Variante bei mir vergurkt.

Die Antwort geht an Günther, aber da fehlt der Antwortenbutton:

Ich müsste mal spaßeshalber nach VirtualBox suchen, wie die bereit gestellt werden.

Ich kenne jetzt die 18er Version nicht, nur die 21er und die 22er. Der einzige Unterschied, den ich da gesehen habe ist, dass in der 22 „ungeprüfte Flatpaks“ nicht standardmäßig angezeigt werden. Die muss man in den Einstellungen einblenden. Gab in der Community auch schon Kritik für den Schritt.

Oder was auch sein kann, du hast nicht die gleiche DE auf dem Notebook wie du manuell installiert hast. Das würde die andere Optik erklären, aber eigentlich sollte der Inhalt der Anwendungsverwaltung gleich sein.

Ich lasse gerade Mint 22 LMDE in einer virtuellen Maschine installieren und schaue es mir in Ruhe an. Mit den ungeprüften Flatpaks ist wohl der Grund, warum die Pakete bei mir nicht aufgetaucht sind – hatte den Punkt eben gesehen.

Der Fehler „Kernel driver not installed (rc=1908) könnte vom EFI Secure Boot herkommen. Muss ich mir genauer anschauen.

Auch die Antwort ist für Günther: Du benutzt die LMDE, das erklärt einiges. Das basiert nämlich direkt auf der Debian Stable, da ist einiges anders als im „normalen“ Mint, das ja auf Ubuntu basiert. Da würde ich persönlich von abraten, das ist aktuell mehr so ein Nebenprojekt von Mint, falls die mal irgendwann von Ubuntu weg wollen. Da fehlt soweit ich weiß auch der Treibermanager, mit dem man recht einfach proprietäre Treiber wie z.Bsp. für NVIDIA installieren kann. Die Hauptentwicklung liegt beim Ubuntu-basierenden Mint. Das funktioniert auch gut mit neuerer Hardware.

Im „normalen“ Mint 22 Cinnamon finde ich in der Anwendungsverwaltung nämlich auch problemlos VirtualBox als Systempaket. Wird bei den anderen beiden DEs Mate und XFCE vermutlich nicht anders sein, da sollte sich nur die Optik unterscheiden.

Ich habe inzwischen beide – Mint 22 und LMDE – letzteres in einer VM zum Test installiert. Es sind wirklich extreme Feinheiten – Mint 22 benutzt den Anwendungsmanager 8.3.3, wo ich dann über „Einstellungen“ ungeprüfte Flatpacks zu- oder abschalten kann. LMDE verwendet dagegen den Anwendungsmanager in der Version 8.2.8 – da ist kein Befehl zur Auswahl der Einstellungen zu finden. Ist mir erst aufgefallen, als ich beide Mint-Varianten in einer virtuellen Maschine als Gäste installiert und dann verglichen habe.

Der Workaround mit der zweiten SSD war dafür gedacht, um ohne extra Backups eine einfache Test und auch Rollback Möglichkeit zu haben.

Das einfache Wechseln setzt voraus, dass das Laptop eine 2,5″ SATA-SSD hat an die man (z.B. bei vielen Thinkpads) mit einer einzigen Schraube rankommt (und keine tief mit vielen Schrauben versteckte m2).

Für solche Zwecke habe ich hier stets einen kleinen Stapel 10€ SSDs liegen, z.B. https://www.amazon.de/dp/B01D3ACJPW/

Viel Erfolg mit dem Projekt und Artikel!

„Ich muss mal sehen, ob ich ggf. nested virtualization aktiviert bekomme – dann könnte ich diverse Linux-Distributionen ein einer VM auf solche Fragestellungen wie „KVM oder Virtualbox installieren“ testen.“

—

Also VM innerhalb einer anderen VM?

Das ist aber schon recht fortgeschritten und ambitioniert.

Solche Experimente sollte man besser gar nicht erst probieren, bevor nicht die erste Stufe der KVM erlernt ist, denn sonst ist das Frustpotential sehr hoch, weil nichts funktioniert und man tagelang unnötig recherchiert.

Sowas wie nested VM braucht man im Alltag nicht.

Es hat sich dank eurer Diskussionsbeiträge inzwischen geklärt. In der Anwendungsverwaltung kann ich die Pakete sehen und installieren lassen, wenn ich ungeprüften Flatpaks zulasse. Habe es gerade getestet – das funktioniert.

Das fehlende Netzwerk in Gästen hängt mit Windows und den deutschen Installationsmedien zusammen (hab das vor einigen Tagen herausgefunden, mein Win 10 Pro Gast hat jetzt Netzwerk).

Der nicht installierbare Kerneltreiber für Virtualbox hing wirklich mit dem Secure Boot im UEFI zusammen. Abgeschaltet und ich konnte Virtualbox funktionsfähig einrichten. Es installiert gerade ein Windows 10 Pro, nachdem ich einige Optionen in VBox angepasst habe. Nun muss ich mal bei Gelegenheit schauen, wie ich die Signatur beim Virtualisierungstreiber für den Kernel hinbekomme, um Secure Boot erneut aktivieren zu können.

Dass ich keine NTFS-Volumes gemountet bekam, weil der Vorgang immer mit einem Fehlerdialog endete, dass das Medium nicht korrekt sei, ließ sich per Konsole über einen Filterbefehl deaktivieren – hatte ich vor einigen Tagen herausgefunden.

Ist aber ein ganz heftiger Aufriss gewesen – wie gesagt, muss mir die Zeit nehmen, das mal aufzuschreiben. Da stolpern möglicherweise noch andere drüber. Wobei: Der Feld-Wald-und-Wiesenanwender wird keine Virtualisierungsexperimente machen.

Nested Virtualization ist was tolles für Nostalgiker:

Informix-Datenbank auf NT4.0 Server (installiert 1998) läuft in einer VM unter VMware-Server 1.0.9 auf Windows Server 2003. Der 2003er-Server läuft dann als VM auf VMware ESXi 6.7 Host.

Gestartet wird das Teil ein paar wenige Male im Jahr, wenn die Konstruktion aus sehr alten Aufträgen Teiledaten aus Stücklisten für Reparatur-Aufträge oder Ersatzkonstruktionen braucht. Die Informix-DB läuft heute schneller als damals direkt auf der Hardware.

Aber zugegeben, als Einstiegsaufgabe ins Thema Virtualization nicht geeignet, eher für die Abschlussprüfung. ;-)

„Dass ich keine NTFS-Volumes gemountet bekam, weil der Vorgang immer mit einem Fehlerdialog endete, dass das Medium nicht korrekt sei, ließ sich per Konsole über einen Filterbefehl deaktivieren“

—

Beim mount-Befehl muss man nur den Parameter „-t ntfs-3g“ mit angeben und das Paket ntfs-3g natürlich auch installiert haben, mehr nicht.

sudo mount -t ntfs-3g /dev/sdb1 /mnt/NTFS-Ordner

Bei dem anderen neu entwickelten experimentellen Kernelmodul „ntfs3“ (ohne das „G“) gibt es Berichte über korrupte NTFS-Dateisysteme.

Deswegen hatte openSUSE dieses Kernelmodul auf eine Blacklist gesetzt.

Im Dateimanager von openSUSE reicht aber ein Klick auf NTFS-Volume und es wird problemlos gemounted.

Wenn man in Arch-Linux ntfs-3g installiert, dann wird auch ein symbolischer Link gesetzt von

/usr/bin/mount.ntfs

zu

/usr/bin/ntfs-3g

Es wird dann also automatisch auf ntfs-3G umgeleitet und der stabile Treiber benutzt, wenn man ntfs mounten will, aber keinen Parameter angibt.

Will man NTFS permanent per /etc/fstab integrieren, dann muss man in der Spalte bei TYP eben „ntfs-3g“ angeben.

/dev/NTFS-partition /mnt/windows ntfs-3g defaults 0 0

Ubuntu (und damit auch Mint) hat aber den experimentellen ntfs3 in den Kernel kompiliert, nicht geblacklistet, keinen symlink gesetzt und benutzt kein ntfs-3g.

Das kann Fehler verursachen.

Man kann auch mehrere LINUX-Distributionen parallel installieren in jeweils eigene Partition.

Für den GRUB-Bootmanager ist sowas gar kein Problem und alle Betriebssysteme inklusive Windows werden automatisch erkannt und in das Bootmenü eingetragen.

„ob ich KVM etc. auf die Schnelle wenigstens in einem Paketmanager auswählen kann. Fehlanzeige.“

—

KVM muss man gar nicht installieren, denn der ist seit über 10 Jahren in allen Linux-Kerneln integriert, also immer vorhanden.

Daher auch das „K“vm, wie Kernel.

Man braucht lediglich eine GUI wie QEMU, um diese KVM bequemer bedienen zu können und die VirtIO-Treiber, damit man die Chips an die VM durchreichen kann.

Ich denke, Du bist schlicht durch Windows verdorben worden ;-)

Ich habe mit Abhängigkeiten in einem Default Debian Gnome weder bei mir noch bei Kunden noch nie Sorgen bei den großen Programmpaketen machen müssen, dafür genau gibt es ja apt, dnf oder pacman, die einem das abnehmen. Zu den anderen Mint Eigenheiten: Greif‘ zum Original und Du hast Ruhe.

Zu dem Begriff „Standardumfang“. Den gibt es so nicht. Du definierst Dir die Tools, die Du haben willst. Die typische Linux installation bei mir sieht immer so aus, dass ich ein minimales Linux installiere ohne grafische Oberfläche und nur mit ssh. Erst dann kann ich gezielt nur das installieren, was benötigt wird.

Hier mal ein Set von von 2-Jahren vom Linux-Presentation-Day:

https://blog.jakobs.systems/pdf/20230322-lpd22-mac2linux-reduced.pdf

Günter schreibt: „Ich habe gerade einige Mint 22-Erfahrungen hinter mir – wo ich aus dem recherchieren nicht heraus kam, weil ich Probleme mit KVM und Windows 10 hatte, NTFS-Volumes wegen eines Bugs nicht gemountet werden konnten etc. Virtualbox bekomme ich nicht zum Laufen, weil der Virtualisierungstreiber im Kernel nicht geladen werden kann – Lösung habe ich noch keine.“

Mit openSUSE Leap wäre das nicht passiert. ;-) Da wäre das mit zwei Klicks erledigt gewesen….

Nur weil die halbe Welt (nach)plärrt, dass Mint ja „sooo einfach und einsteigerfreundlich“ sei, muss das noch lange nicht stimmen. Es ist und bleibt ein Derivat eines Derivats, mit zugegeben hübscher Oberfläche.

Sobald man jedoch etwas tun möchte, was vom installierten Standard abweicht – bei Ihnen KVM und Virtualbox – geht die Handarbeit (auch „frickeln“ genannt) los. Abgesehen davon, dass selbst Abweichungen vom (nicht optimalen) Standard der Installation schwierig zu machen sind (prof. Verschlüsselung, Suspend-to-Disk, swap-Anpassung etc.)

Das betrifft allerdings viele Distributionen, weshalb man eher auf die mit professioneller Nutzerbasis setzen sollte (openSUSE, RedHat-basierte, Ubuntu meinetwegen auch).

Nur – und da gebe ich Ihnen recht – ist es dem (Neu)Einsteiger kaum zuzumuten, zur Distributionssuche unter Hunderten die Richtige zu recherchieren. Da wird dann oft zu der gegriffen, die gerade „angesagt“ ist.

> Das betrifft allerdings viele Distributionen, weshalb man eher auf die mit professioneller Nutzerbasis setzen sollte (openSUSE, RedHat-basierte, Ubuntu meinetwegen auch).

Ich bin gerade getroffen und empört, dass Du Debian nicht nennst und statt dessen Ubuntu ein „meinetwegen“ gibst…

Pfffft! :-)

Ja ich weiß :-D Ich hab dabei nur darauf abgestellt, dass es für Ubuntu als (auch) professionell supportetes OS auch ein professionelles Entwicklerteam gibt; Debian als Community-System schließe ich selbstverständlich mit ein.

Debian seit Version 6 wird auch von den Astronauten der NASA eingesetzt.

Die NASA wollte ein möglichst wartungsarmes und zuverlässiges Betriebssystem auf den Laptops der Astronauten haben, weil der Support in der Umlaufbahn schwieriger ist und zu viel Zeit und Nerven kosten würde.

Debian hatte sich damals als Testsieger herausgestellt.

Vorher wurde Windows XP benutzt.

Windows 7 wäre aus heutiger Sicht vermutlich auch gut genug gewesen, allerdings war es damals noch zu jung, so dass man es nicht sicher wusste und auf Nummer sicher gegangen ist.

Günter schreibt : „…und auch das Notebook mit Linux Mint 22 muckt diesbezüglich nicht.“ – Ich warte gespannt auch deinen ersten Erfahrungsbericht als Blogbeitrag zum Thema „Linux Mint und Ich“

Hat jemand mal bitte einen Profi-Tipp, wie man den DNS-Client Dienst in Windows 10 abschalten kann?

Im Dienste-Dialog sind die Optionen für Beenden und Deaktivieren ausgegraut (im Gegensatz zu Win7).

Auch in einer Konsole mit Admin-Rechten wird das Beenden des Dienstes verweigert.

Hintergrund:

Wenn ich meine hosts Datei reinkopiere, dann macht der Firefox gar keine neue Seite mehr auf, weil dieser Windows-10-Vollkernschrott diese hosts nicht mehr verarbeitet bekommt.

Die Bremse ist der DNS-Client-Dienst, den man auch unter Win7 bei großer hosts-Datei abschalten sollte, was in Win7 auch völlig problemlos möglich ist und es zu keiner spürbaren Verzögerung durch die hosts-Verarbeitung kommt.

Win10 hingegen ist da völlig am Ende und nichts geht mehr.

Das ist ein Unterschied von mehr als Faktor 1000.

Da ich hier noch nie solche Meldungen gelesen habe, nehme ich mal an, ihr benutzt die hosts gar nicht oder ihr kennt da einen Profi-Trick, der mir bisher entgangen ist.

2.

Applocker funktioniert in Win10 auch anders als in Win7.

Blockt man den Desktop, dann lassen sich trotzdem exe auf dem Desktop starten, trotz Regel-Erzwingung, trotz laufendem Anwendungsidentitäts-Dienst, trotz gpupdate /force , dafür geht dann das Startmenü nicht mehr auf.

Dieselben Regeln funktionieren auf Win7 tadellos, aber Win10-Applocker macht da offenbar mindestens zwei Sachen katastrophal falsch.

Getestet auf IoT LTSC 2021.

3.

Support-Ende?

Gab es denn jemals Support?

Updates sind allesamt Schrott und bauen zusätzliche Bugs ein.

„Funktionen“ funktionieren aktuell nach vielen Jahren der Entwicklung immer noch nicht, wenn man diese mal testet.

Dienste kannt du auch in der Registry abschalten.

DNS-Client:

HKLM/System/CurrentControlSet/Services/Dnscache/Start.

Wert von 2 auf 4 ändern.

Dann System neu starten und der Dienst ist deaktiviert.

0 = Bootstart (wird afaik nur bei Treibern genutzt)

1 = Systemstart (wird afaik nur bei Treibern genutzt)

2 = automatischer Start

3 = manueller Start

4 = deaktiviert

Falls Windows beim Ändern des Wertes herumzickt muß man noch die Rechte des Registryschlüssels ändern, evtl. sogar den Besitz übernehmen.

Der DNS-Client ist aber als Abhängigkeit von zwei anderen Diensten eingetragen, die dann ebenfalls nicht mehr funktionieren. Das war bei Win7 noch nicht so.

Vermutlich ist das auch der Grund, warum sich dieser Dienst nicht beenden lässt, bevor nicht die anderen abhängigen Dienste ebenfalls beendet wurden.

Microsoft hat da ein ganzes Netz von gegenseitigen Abhängigkeiten eingebaut, welches im Prinzip völlig unnötig wäre, wie Win7 bewiesen hatte.

Durch dieses Abhängigkeiten-Labyrinth wird der Administrator in seinen Handlungsmöglichkeiten beschränkt.

Registry-Trick kannte ich schon, habe ich aber tatsächlich in diesem Fall noch nicht getestet, mache ich gleich.

Registry funktioniert allerdings prinzipiell nicht on-the-fly sofort, sondern erst nach Neu-Login oder gar nach Reboot.

Das ist suboptimal, falls es hier überhaupt so funktioniert.

Wenn ich als Admin in einer Konsole oder direkt im Dienste-Dialog (services.msc) befehle, der Dienst soll beendet werden, dann hat Windows das gefälligst auch genau so auszuführen, anstatt mich bevormunden zu wollen.

Mit dem Registry-Eintrag ist der DNS-Cache-Dienst nach dem Neustart deaktiviert, ok.

Allerdings lassen sich dann die Dienste Netzwerkkonnektivitäts-Assistent und RAS-Verbindungsverwaltung nicht mehr starten, weil die von diesem DNS-Cache-Dienst abhängig sind.

Ob man die allerdings wirklich braucht weiß ich nicht.

Unter Win7 gibt es den Netzwerkkonnektivitäts-Assistent gar nicht und die RAS-Verbindungsverwaltung hatte ich dort auch deaktiviert, ohne bisher bekannte Probleme.

Microsoft baut immer irgendwelchen Blödsinn ein, der im Grund völlig unnötig ist und nur Probleme verursacht.

Ich erinnere mich gut an die gleichartige Kampagne zu Windows 10.

Das hieß damals „GWX“ aka „Get Windows 10“.

Der Abschalt-Hack war dazumal in der Registry dieser „DisableGWX“ Wert, der „GWX.EXE“ abbiegen ließ.

Man müsste es halt reproduziert kriegen, aber das wird bei MS garantiert bekämpft und sie werden die Initiative nicht aufgeben.

Vielleicht isses ja „DisableGWXI“ oder „DisableGWY“, hehe :)

Microsoft hat mit der Veröffentlichung des Store einen strategischen Fehler gemacht.

Damit wurde nämlich das Geschäftsmodell von Valve (Steam) bedroht, falls Microsoft Sideloading außerhalb des Store verbieten sollte.

Valve hat deswegen nach Alternativen gesucht und innerhalb der letzten 6 Jahre Proton für Linux entwickelt, mit dem man dann auch native Windows-Spiele auf Linux benutzen kann.

Das funktioniert inzwischen so gut, dass manche Windows-Spiele auf Linux mit 30 Prozent besserer Framerate laufen (Far Cry 5) als unter Windows, obwohl Linux zusätzlich die DirectX-Befehle in Vulkan-Befehle bzw OpenGL-Befehle übersetzen muss.

Daran kann man sehen, wie grottig Windows und dessen DirectX-Implementierung ist.

Heute kann man Nobara- oder Bazzite-Linux installieren und sofort Spiele starten, ohne etwas nachinstallieren oder konfigurieren zu müssen, denn Steam, Proton, Lutris, Wine etc ist alles schon integriert und zwar richtig professionell, denn es wird von ehemaligen Softwareentwicklern von Red Hat gemacht und Nobara und Bazzite basieren auf Fedora, dem freien Linux von Red Hat und der Nobara-Erfinder und Betreuer Thomas Crider (Nickname „Glorious Eggroll“) hat jahrelange Erfahrung mit Spielen auf Linux. Seine Initialen „GE“ bezeichnen die verbesserte Proton-Variante „Proton GE“.

Wine ist inzwischen auch so gut geworden, dass Microsoft Office 2016 auf Linux laufen kann.

Microsoft muss also aufpassen, dass deren Geschäftsmodell nicht in Kürze wegbricht, denn Web-Browser, email, Office, Spiele laufen auf Linux sehr gut.

Die verbleibenden Probleme in Linux beziehen sich auf Treiber, CAD, Adobe-Software und Kopierschutz- und Anti-Cheat-Methoden mittels Kernel-Modulen.

Windows kann diese Nische noch ausfüllen, aber wie lange noch?

Win 11 kann man doch per Grupppenrichtlinie blockieren:

Computerkonfiguration > Administrative Vorlagen > Windows-Komponenten > Windows Update > Windows Update für Unternehmen > Zielversion des Funktionsupdates auswählen -> dort aktuelle Windows Version eintragen.

Bei mir ist seit dem Ruhe.

Geht auch per Registry.

Beide Versionen sind hier genau beschrieben:

https://www.netzwelt.de/anleitung/199084-windows-11-upgrade-blockieren-windows-10-beibehaltenso-gehts.html

Also ich mache auch gerade Schritt für Schritt eine Umstellung auf Linux … aber schön langsam und behutsam.

Als ITler bin ich aber mit Linux schon seit mehreren Jahren beruflich und privat vertraut und habe nur auf dem Hauptrechner einfach noch nicht den Sprung geschafft.

Mein Laptop für unterwegs ist bereits auf Linux Mint und der Haupt-PC hat schon ein Dual-Boot mit Debian (KDE). Und der LAN-PC (#FirstWorldProblem) wurde nun mit Fedora beglückt.

Meiner Meinung nach gibt es kein falsches Linux – also Linux Distribution. Manche sehen das als Fluch an, wenn es eine zu große Auswahl gibt, für mich ist es ein Segen :-)

Da mein 10 Jahre alter PC nach MS-Lesart nicht W11-tauglich ist, denke ich, ich werde von derartigen Belästigungen verschont bleiben. Angezeigt wurde mir jedenfalls noch nichts.

Da ich alles abgedreht habe wo MS mir was reinschieben könnte sehe ich auch keine Belästigungen.

Und auch wenn hier immer wieder einige das Gegenteil behaupten, da ich keine Belästigungen/Übergriffe sehe weis ich das ich alles richtig gemacht habe!

W10 läuft hier jedenfalls mindestens bis 2029 Problemfrei und wahrscheinlich auch noch darüber hinaus.

Bei Windows finde ich auch seltsam, dass die WinRE.wim verschoben anstatt kopiert wird, wenn man Windows manuell per dism installiert und dann mit Reagentc /setreimage die Wiederherstellungspartition erzeugt.

Die WinRE.wim fehlt dann in c:\windows\system32\recovery obwohl sie nach dem dism noch dort war.

Diese fehlende WinRE.wim war schonmal eine der Ursachen für einen fehlerhaften Patch. Die vorhandene WinRE.wim in der Wiederherstellungspartition liegt manchmal in einer zu kleinen Partition, so dass das Updaten dort dann ebenfalls nicht mehr funktioniert. Da hat dann die Setup.exe Mist gebaut.

Wohin man auch schaut, nur noch Bugs Bugs Bugs.

Wenn man mal manuell Windows per Konsole installiert (dism, bcdboot, Reagentc), dann sieht man erstmal, wie lächerlich die Hardware-Beschränkung in der Setup.exe ist.

Dism umgeht das einfach und es gibt keine Probleme. Das ist so wie wenn man ein ZIP auspackt und einem ZIP ist es auch völlig latte, was in dem ZIP drin ist oder welche CPU in der gar nicht gestarteten Setup.exe abgefragt wird.

Man kann sogar mehrere unterschiedliche Windows 10 oder 11 parallel auf echte Festplatte installieren, inklusive Bootmanager und WinRE-Partition ohne Windows 7 überhaupt verlassen zu müssen.

Ich finde da hat Microsoft gepennt, dafür nicht ein praktisches Tool gebaut zu haben, welches Drag and Drop des gesamten Betriebssystems auf eine andere HD oder Partition erlaubt.

Das ist nämlich total primitiv mit ganz wenigen Befehlen zu bewerkstelligen.

Es gibt nur einen Speicherort. WinRE findet sich, mit eingeschränkter Funktion, nur auf der OS-Partition, wenn keine Wiederherstellungspartition erstellt werden konnte.

„Der Hintergrund ist, dass einmal der Support von Windows 10 für die meisten Benutzer im Oktober 2024 ausläuft.“

Bitte oben im Beitrag das Datum auf 2025 ändern.

Das Support ende von Windows 10 liegt im Oktober 2025.

Das Microsoft Werbung für Windows 11 macht ist völlig normal. Man möchte halt kein drittes Windows 7 oder Windows XP haben.

Auf 2019 LTSC ist nichts derartiges zu sehen. Allerdings sind im BIOS SecureBoot und Co. auch aus, vielleicht kommt die Werbung bei fehlender Windows 11 Eignung auch nicht (und es hat ja noch bis 2029 Zeit).

Was die Diskussion Windows vs. Linux betrifft, habe ich hier Windows 10 LTSC, RHEL Clones, und auch Ubuntu herumstehen, und kann guten Gewissens sagen, dass alle auf ihre eigene Art und Weise nerven. Darum habe ich weder Windows aufgegeben, noch bin ich ganz auf Linux umgestiegen. So ein alter Computersaurier wie ich will einfach irgendwann nicht mehr dauernd ‚herumschrauben‘, sondern Zeug soll einfach ohne Aufwand und grosse Kosten wie von mir(!) gewünscht funktionieren.

Aber wenn natürlich irgendwann mit Windowsupgrades nichts mehr geht oder Cloud-Only kommt, wird wohl alles entweder Windows-offline konfigiert, oder es muss doch mehr Linux her.

Es gibt außer absoluten Nischenfällen im privaten Bereich keinen Grund mehr, auf den MS Kram zu setzen.

Also Linux ja Linux das Betriebssystem für Steven Hawking und Elefanten, was haben Elefanten mit einem Astrophysiker gemein?

Nun beide haben ein schier übermenschliches Gedächtnis, Steven Hawking braucht kein nautilus er braucht nur „ls -R /“.

Was will ich wohl damit sagen? Das CLI für den Popo ist, ich kenne keinen einzigen Linux admin welcher aus dem Gedächtnis arbeitet die haben alle ein ganzen Haufen an cheet sheets, console history dumps und der gleichen. Wenn man ihnen eine installations CD und ein PC ohne Zugang zu Google oder ihren Notizen hin stellt können diese Menschen ihre Arbeit nicht verrichten.

Steven Hawking hätte es gekonnt der hatte ein Gedächtnis wie ein Elefant.

Mit GUI ist das was anderes, Windows Admins können ziemlich viel ohne Notizen, Spickzettel und Google erreichen.

Das liegt daran das man durch eine GUI mit den assoziativem Gedächtnis Navigieren kann und auch mit Schlussfolgerungen und nachdenken weiter kommt.

Bei einer CLI ist man meist ohne ein how to aufgeschmissen –help hilft nur bei dem einfachsten.

Und das ist ein großes Problem, Windows ist inclusive man kann leicht als Noob anfangen und sich Schritt für Schritt Kenntnisse aneignen, und sich langsam zu einem power user entwickeln.

Mit Linux funktioniert das nicht da hat man nach 10% des Weges schon die ersten 3% vergessen. Eine Linux expertise baut man sich in einer Spickzettel Sammlung auf, eine Windows expertise kann man sich im eigenem Kopf aufbauen.

Was mich vor allem frustriert ist das das windows seid 10 ihre einst so power user freundliche GUI zum wohle von Appleesken modernen deepen UI’s aufgibt und den admins sagt nutzt doch power shell.

Das ist nicht gut damit werden mehr und mehr Menschen davon abgehalten sich Expertenwissen an zu eignen, die Einstiegshürden werden angehoben und mehr Menschen werden „dumm“ gehalten.

Linux könnte so viel besser sein wenn sie mal mit der GUI ernst machen würden und die GUI so weit brighten das man alles ohne die exotischen Sachen nur mit der GUI einrichten und konfigurieren könnte ohne die CLI zu brauchen und Config Files zu editieren.

Deswegen hat openSUSE das YAST-Tool erfunden.

Damit kann man vieles in einer GUI erledigen.

Bei MX-Linux gibt es die MX-Tools.

Eine allumfassende GUI wird es aber vermutlich niemals geben können, weil nicht vorherbestimmt ist, was mal ein Admin oder User machen möchte. Das muss alles frei und flexibel sein und so bleiben, damit man Befehle kombinieren und in Scripten zusammenfassen kann.

Solche Scripte kann man ja speichern und per Befehl in Konsole oder GUI-Button oder per Startmenü-Eintrag starten.

Das alles im wohlmeineneden Sinne, weil Du stark bedrohst bist, ohne es zu wissen:

Wenn man auf einen Rechner klettern muss, um etwas nachzuschauen, ist offensichtlich das Monitoring kaputt. Wenn man auf einen Rechner klettern muss, um etwas zu ändern, ist offensichtlich die Automatisierung kaputt und vermutlich, hoffentlich, nicht nur die eine Kiste kaputt, sondern alle andern auch und zwar hoffentlich gleich.

Soviel zu GUIs oder dem manuellen Herumklickern in irgendwelchen Oberflächen auf irgendeinem Server. Ohne Automatisierung, keine Skalierung. Ohne Skalierung keine Redundanz.

Du wirst eher früher denn später durch ein Bash, Ansible oder Puppet-Skript ersetzt werden wenn Du nicht an Deinem Mind-Set arbeitest.

Ein Skript. von Dir so belächelt mit Snippet-Sammlung, Cheat-Cheets und Spickzetteln erstellt, wird Dich obsolet machen, weil Dein Arbeitgeber Dich zusammen mit einer tollen Klicki-Bunti Software nicht mehr braucht. Beispiel gefällig?

https://blog.jakobs.systems/blog/20240908-gitops-veeam-ersatz/

Wozu brauche ich eine Skalierung wen ich immer nur einzelne individuelle Configurationen brauche?

Hältst du mich für einen IT Dienstleister oder so was?

Ich bin experimental Physiker und die Stümper von der uni IT kommen mir nicht an meine labor PC’s.

Oh ein Physiker in seinem Elfenbeinturm. Dann lasse ich Dich in Ruhe. Wusel weiterhin vor Dir, nur erliege bitte nicht der fälschlichen Annahme, die Welt außerhalb Deines Labors sei genauso wie um Dich herum.

Als Physiker sollten Die Baselines ja bestens bekannt sein, hier einige zu Microsoft:

https://blog.jakobs.systems/micro/20230325-microsoft-im-web-bedeutungslos/

Ich habe mal eine Registry zusammengestellt, wie man Spotlight und diverse Nag-Ads deaktivieren kann.

Das sind ca 50 Registry-Einträge und die Liste ist vermutlich immer noch unvollständig:

pastebin. com/1pSj1edg

Wie man anhand dieser wechselnden 6-stelligen Nummern sehen kann hat Microsoft vor, sehr viele Benachrichtigungen zu verschicken.

„SubscribedContent-338393Enabled“

Solche Benachrichtigungen werden schon seit Februar in Wellen verteilt. Stand auch im Windows-Insider-Blog zum KB5035941:

“ you might see a message that invites you to upgrade to Windows 11. This message only appears if your device is eligible for an upgrade. Note this feature might not be available to all users because it will roll out gradually.“

Ein paar dieser Benachrichtigungen kann man auch über die Systemsteuerung abschalten, unter „Benachrichtigungen und Aktionen“. Dort gibt es einen Schieber und 6 Kästchen zum abhaken.

Spotlight (Blickpunkt) ist über diverse andere Dialoge verteilt. Newsfeeds ist wieder anderswo abgelegt.

Eine einzige Seuche ist das geworden.

Moin.

Nun der Mitleser, der seit Win 3,1 auf Floppy mit Win arbeitet.

Hab schon x-mal an Linux Wechsel gedacht.

Nur ist mir Linux ein Rätsel, denn da gibt es X-Versionen und Begriffe wo man als kompletter Linux Neuling nicht durchsteigt.

Bei Win ist das einfach: XP, 7, 10, 11 sonst was.

Vielleicht noch Basic Version oder irgendwas mit Proffessional, fertig.

Damit gehts schon Los, welches Linux?

X-Abspaltungen.

Und noch wichtiger: laufen alle Windows Programme da oder nicht?

Wenn das kein Heim 08-15 PC ist für bissl Surfen, Mail und Daddeln, dann hat man, so wie ich, seine 10-20 Programme drauf die man braucht (Arbeit),

und wenn die nicht Laufen war es das.

Dann noch: Wie einfach ist der Umzug, also wie kommen die ganzen Windowssachen ohne Schaden zu nehmen auf das Linux?

Da steht der „Normalo“ auf einsamen Posten, und bleibt dann lieber beim Windows, das Funktioniert ja auch.

Es müsste einfach einfach sein zu wechseln.

Anfänger Linux runter laden, Installieren, Windows-Zeugs automatisch importieren lassen, fertig.

Das würde bestimmt einige anlocken, aber so, komplett allein gelassen?

Wollte selbst so oft wechseln, aber die Arbeit geht vor, das Risiko das nachher nichts mehr geht, abgesehen davon das es anfangs sowieso harkt, ist zu groß.

Guter und vernünftiger Punkt.

Was viele vergessen: Will „Linux“ denn wirklich für jeden sein? Es ist ein Betriebssystem, so wie andere Unix-Systeme, mit denen man sich beschäftigen muss, um es sinnvoll und SICHER zu nutzen.

Wer es einfach will: Produkte eines großen Anbieters mit Sitz in Cupertino nutzen. Teuer, eigenwillig und ja, auch einfach.

Und da läuft dann die Windows-Software, die man für die Arbeit braucht? Oder auch nicht.

Das Spiel endete bei einem Bekannten damit, dass wieder ein Windows-PC ins Büro kam und der iMac ins Spielzimmer.